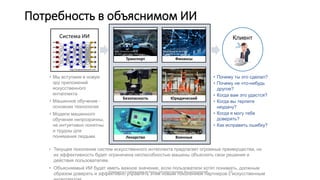

Документ обсуждает важность объяснимого искусственного интеллекта (XAI) в контексте повышения доверия пользователей к системам AI. Он представляет проблемы, связанные с отсутствием прозрачности и возможностью объяснения решений AI, а также предлагает принципы XAI, разработанные для улучшения понимания и доверия к технологиям AI. Основное внимание уделяется необходимости обучения систем AI, которые могут эффективно объяснять свои действия пользователям, чтобы избежать ошибок и поддерживать доверие.

![• Нейроморфный искусственный

интеллект

Компьютеры Фон

Неймана

Нейроморфные

компьютеры

Сложность

компьютера

Т.e.вентили;

память;

нейроны;

синапсы

мощность;

размер

[log]

•Производительность на уровне

человека

•Заря новой эры

Заря новой

парадигмы

“простая” “сложная”

Сложность Среды

Например, количество входных

комбинаций

[log]

Цель Программы

Разница между

универсальностью и

эффективностью

Кортекс

человека

Симуляция

кортекса человека

15 ватт 1010 ватт

I литр 4x 1010 литров

Проблема

• По сравнению с

биологическими системами

интеллектуальные машины

в 1000 раз менее

эффективны в сложной

среде.

• Чтобы интеллектуальные

машины были бы полкзны

их нужно сочетать с

биологическими

системами.

Цель

• Развить технологию

электронные

нейроморфные машины

сравнимую с

биологоческим уровнем.](https://image.slidesharecdn.com/random-240912043226-a588ae13/85/clssifying-images-using-artificial-intelligence-4-320.jpg)