20/09/17 DevC Seongnam Opening Event

https://festa.io/events/1158

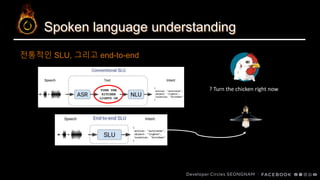

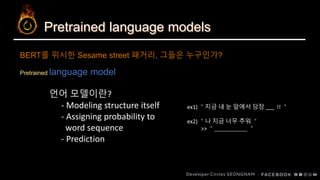

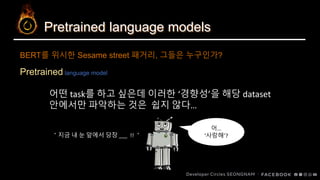

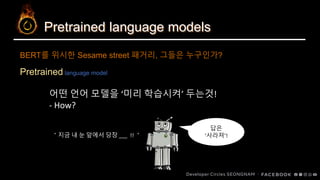

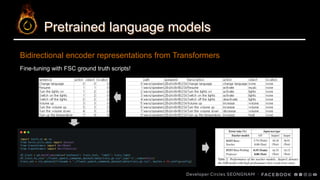

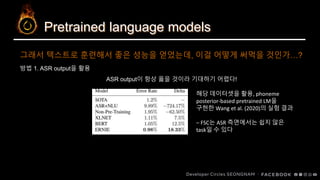

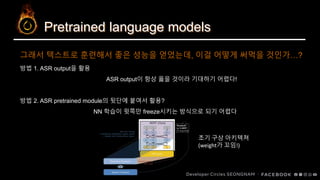

SLU? BERT? Distillation? 그게 뭔데… 어떻게 하는 건데… (feat. PyTorch)

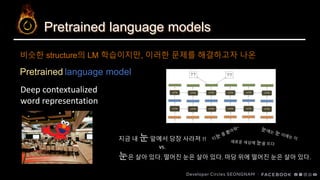

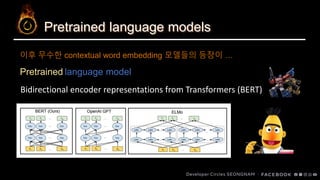

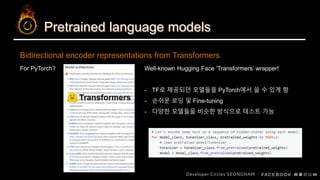

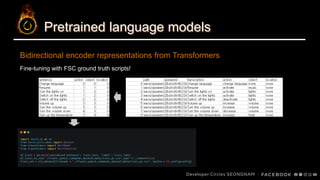

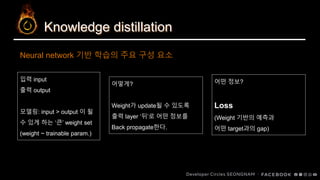

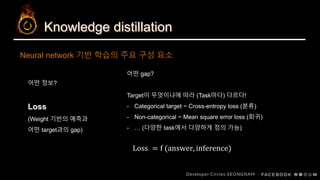

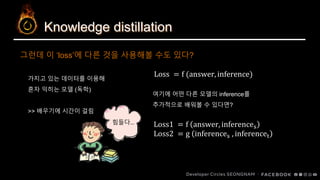

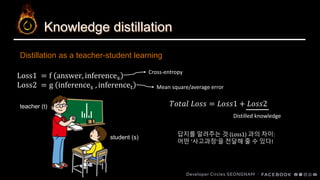

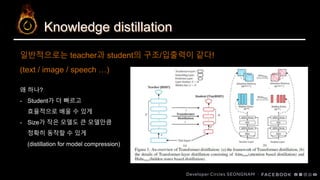

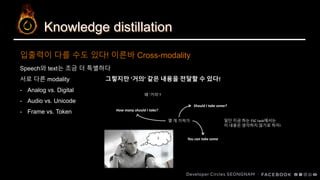

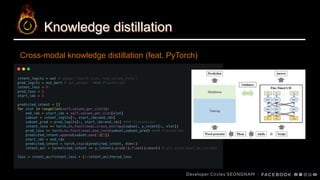

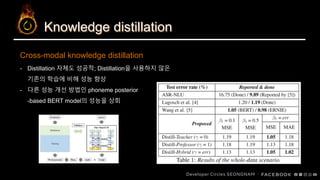

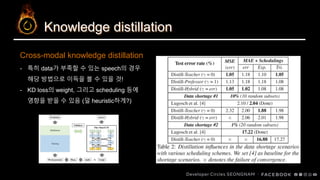

본 talk에서는 음성으로부터 intent를 추출하는 SLU task에 BERT와 같은 pretrained langauge model을 적용하는 과정에서 직접적으로 적용하는 것의 난점과 knowledge distillation으로써 이를 해결하는 과정에 대해 다룹니다.