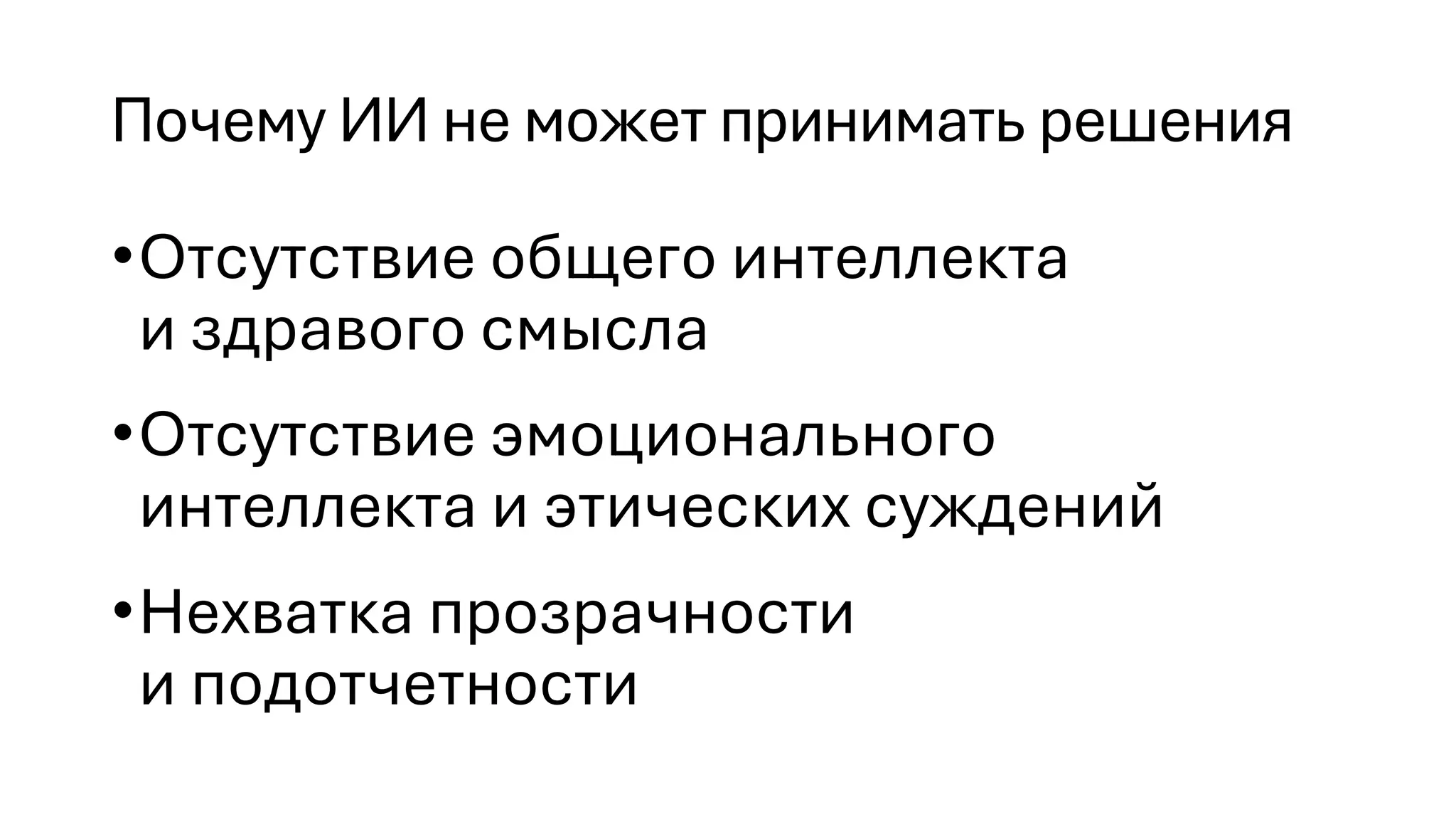

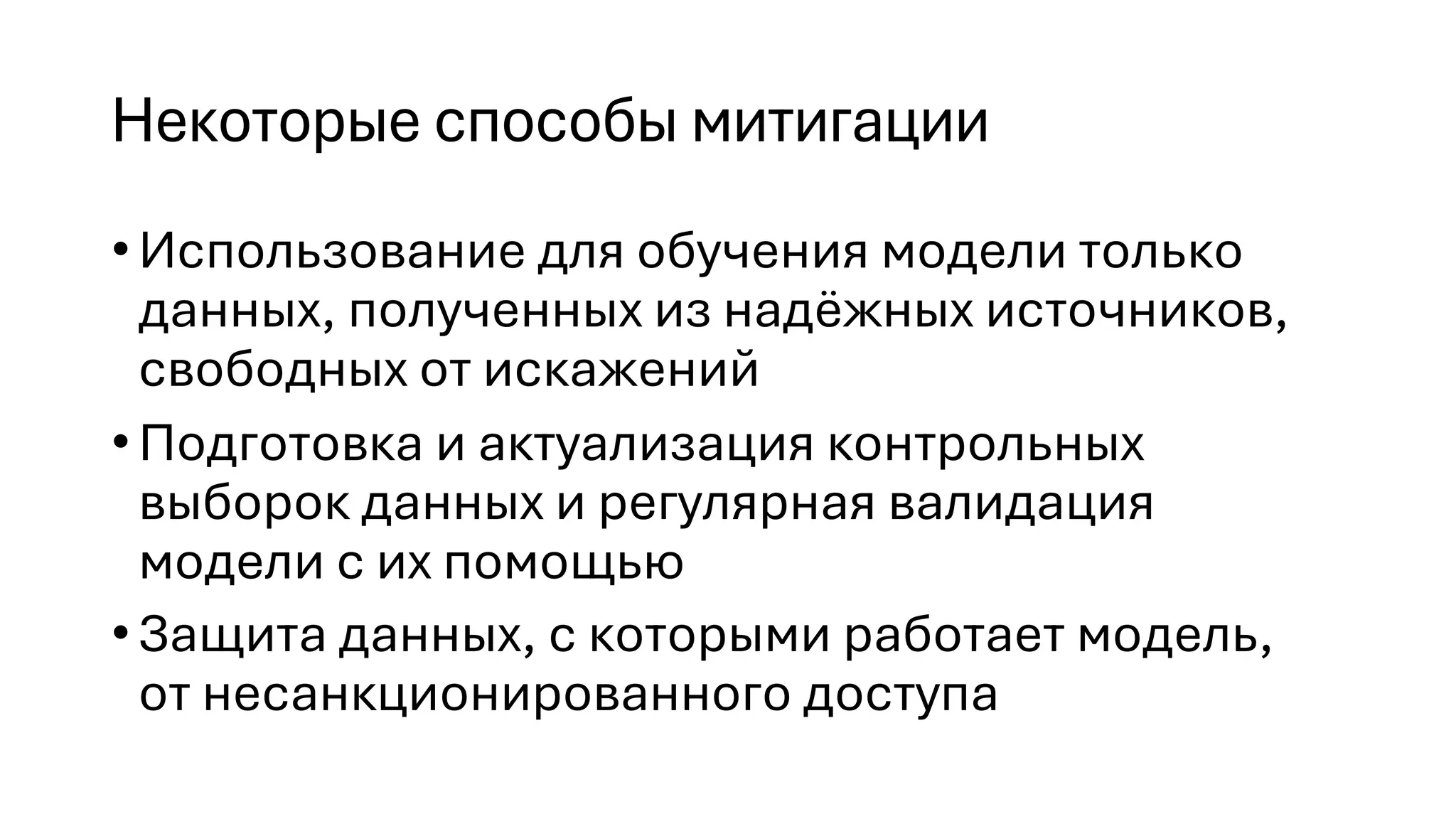

Документ рассматривает риски, связанные с искусственным интеллектом, подчеркивая отсутствие общего интеллекта и эмоционального восприятия у ИИ, что ограничивает его способность принимать этические решения. Описаны основные киберриски, связанные с ИИ, такие как инъекции, утечки данных и ненадлежащая обработка запросов, а также предлагаются стратегии для их смягчения. В завершение подчеркивается, что полного решения проблем не существует и важно формировать модели угроз и контроль безопасности.