Lablup Conf 1st (Session7/Cases)

"People don't know what they want until LABLUP show it to them. : Practical guide to building GPU clusters for AI" - 김정묵

- 발표내용 :

* 교육부터 하이퍼스케일 AI 모델 개발까지, GPU Cluster 구축과 운영을 준비하실 때 미리 고려하실 사항들을 사례와 함께 공유드립니다.

- 영상보러가기 : https://youtu.be/GMYWKF993J8

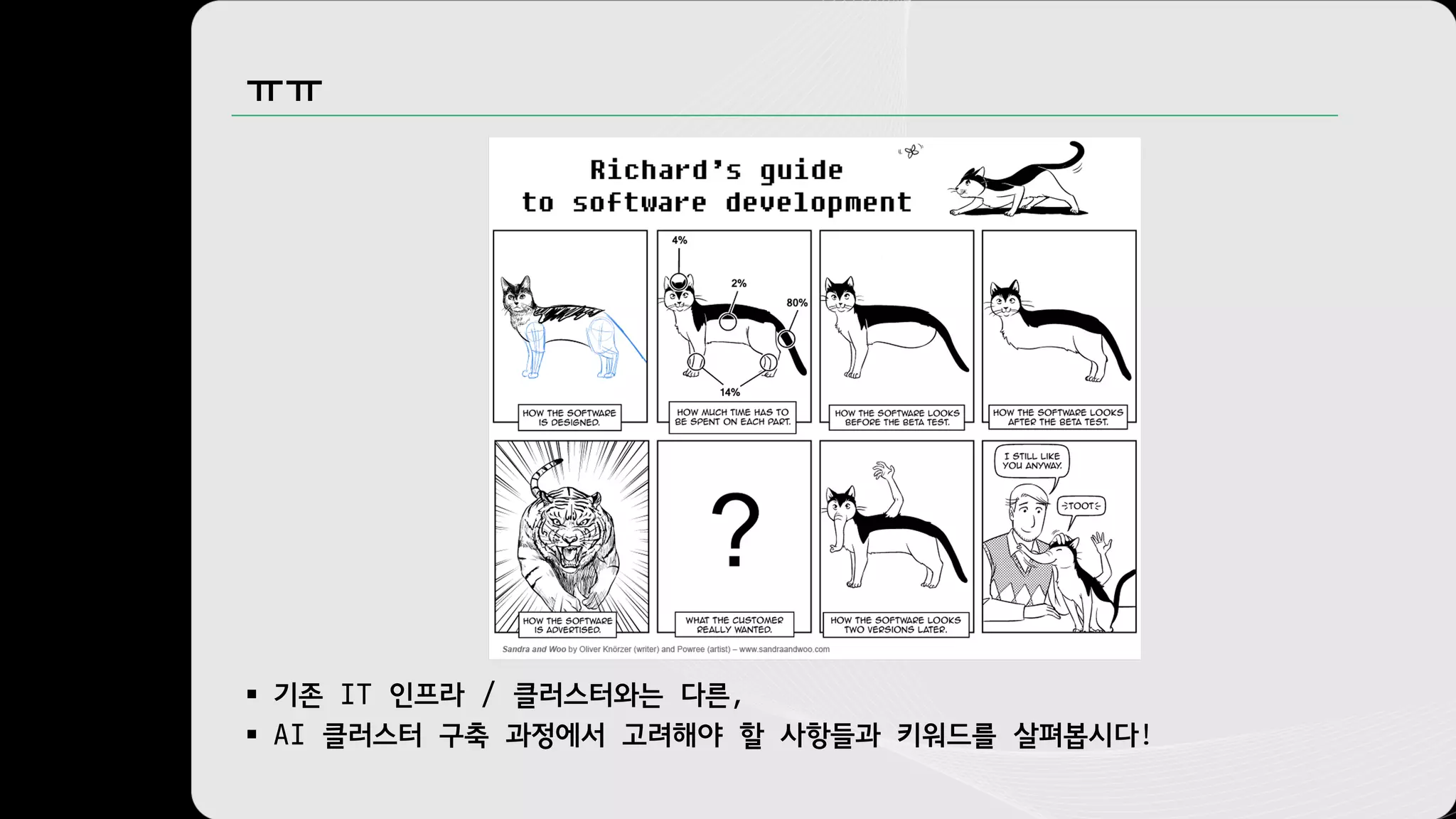

![[실화] GPU(만) 많은 AI 클러스터

§ CPU / RAM 부족해서 데이터 처리 기다리며 GPU는 항상 놀고 있음

§ 데이터 / 컨테이너 이미지 불러오느라 CPU / GPU 다 놀고 있음

§ GPU 간 통신이 지원되지 않아 GPU 는 많아도 모델 사이즈 제한

§ 어느 데이터가 어디에 있는지 몰라 중복 / 보안 이슈로 클러스터링 불가

§ Rack 당 3kW? 단일 노드 10kW, 공사비 폭탄

§ 높은 복잡도와 관리 부담에 관리자 퇴사](https://image.slidesharecdn.com/lablupconf-session7-211128141055/75/Lablupconf-session7-People-don-t-know-what-they-want-until-LABLUP-show-it-to-them-Practical-guide-to-building-GPU-clusters-for-AI-4-2048.jpg)