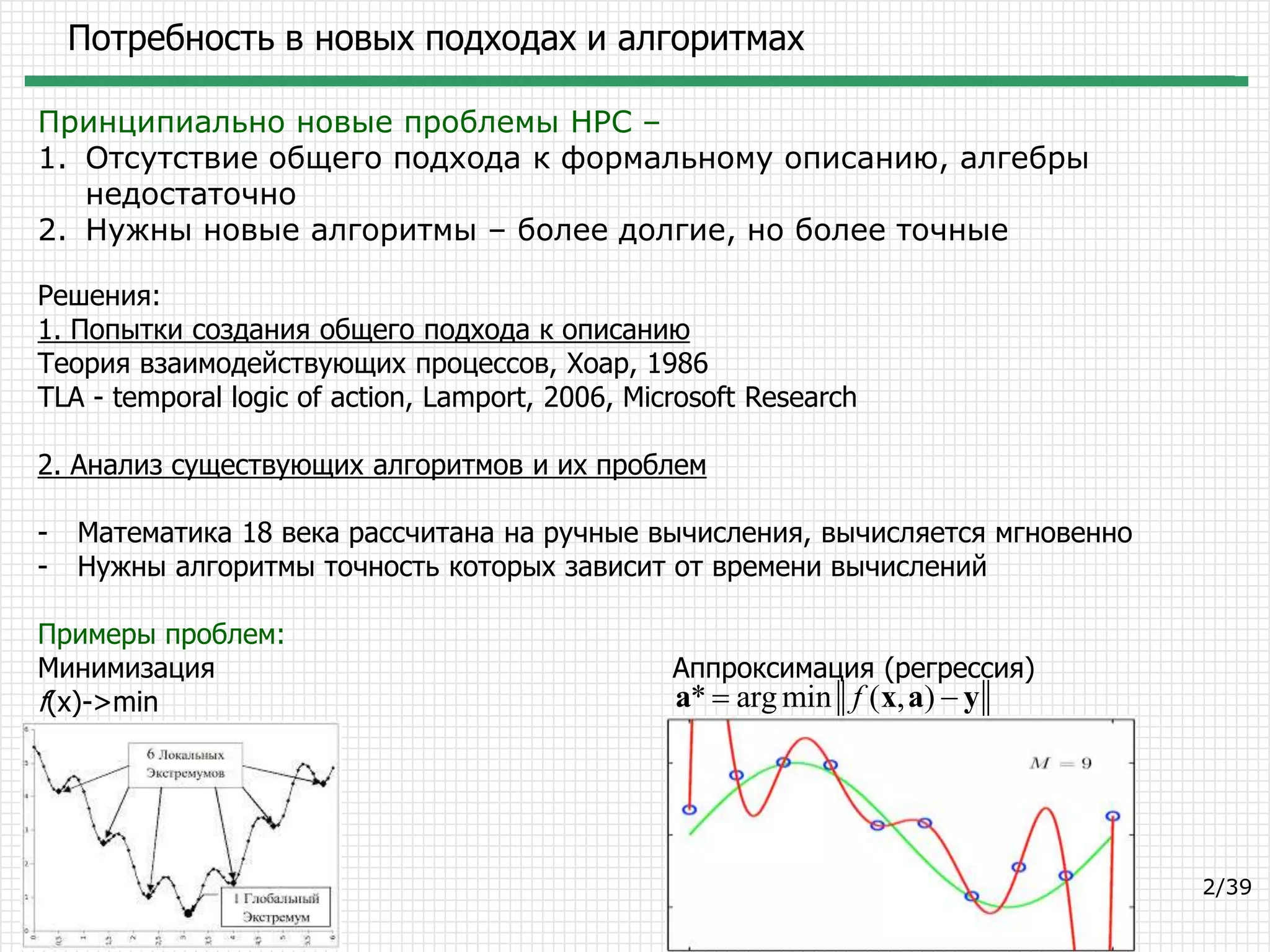

Документ обсуждает потребности в новых подходах и алгоритмах в области глубокого обучения и сверточных сетей. Основное внимание уделяется анализу существующих алгоритмов, предложениям по их улучшению и новым методам, таким как генетические алгоритмы и метод опорных векторов. Также рассматриваются архитектуры нейронных сетей и их применение в различных задачах, таких как классификация и сегментация.

![Сверточные сети – Базовые слои

Convolution – Свёрточный слой

RELU – Линейный с насыщением

POOL – Pooling, DropOut

FC – Полносвязный слой

LRN – Нормировка данных

Примеры конфигураций:

INPUT -> FC

INPUT -> CONV -> RELU -> FC

INPUT -> [CONV -> RELU -> POOL]*2 -> FC -> RELU -> FC

INPUT -> [CONV -> RELU -> CONV -> RELU -> POOL]*3 -> [FC -> RELU]*2 -> FC](https://image.slidesharecdn.com/nikonorovtruepositive-160415194837/75/Deep-Learning-and-Convolutional-Networks-17-2048.jpg)