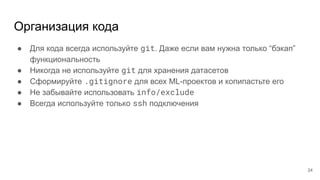

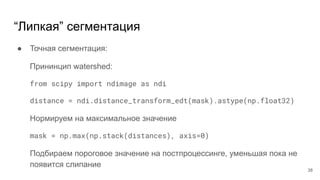

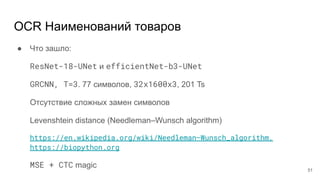

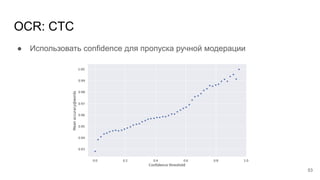

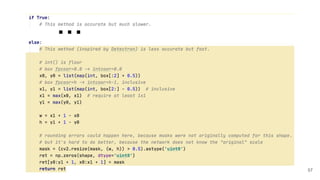

Документ описывает методы автоматизации мониторинга ценников товаров с использованием технологии распознавания и глубокого обучения. Обсуждается опыт компании, включая создание пайплайна и применение различных инструментов и библиотек, таких как PyTorch и OpenCV. Также представлены практические советы по организации работы с данными и улучшению качества распознавания.