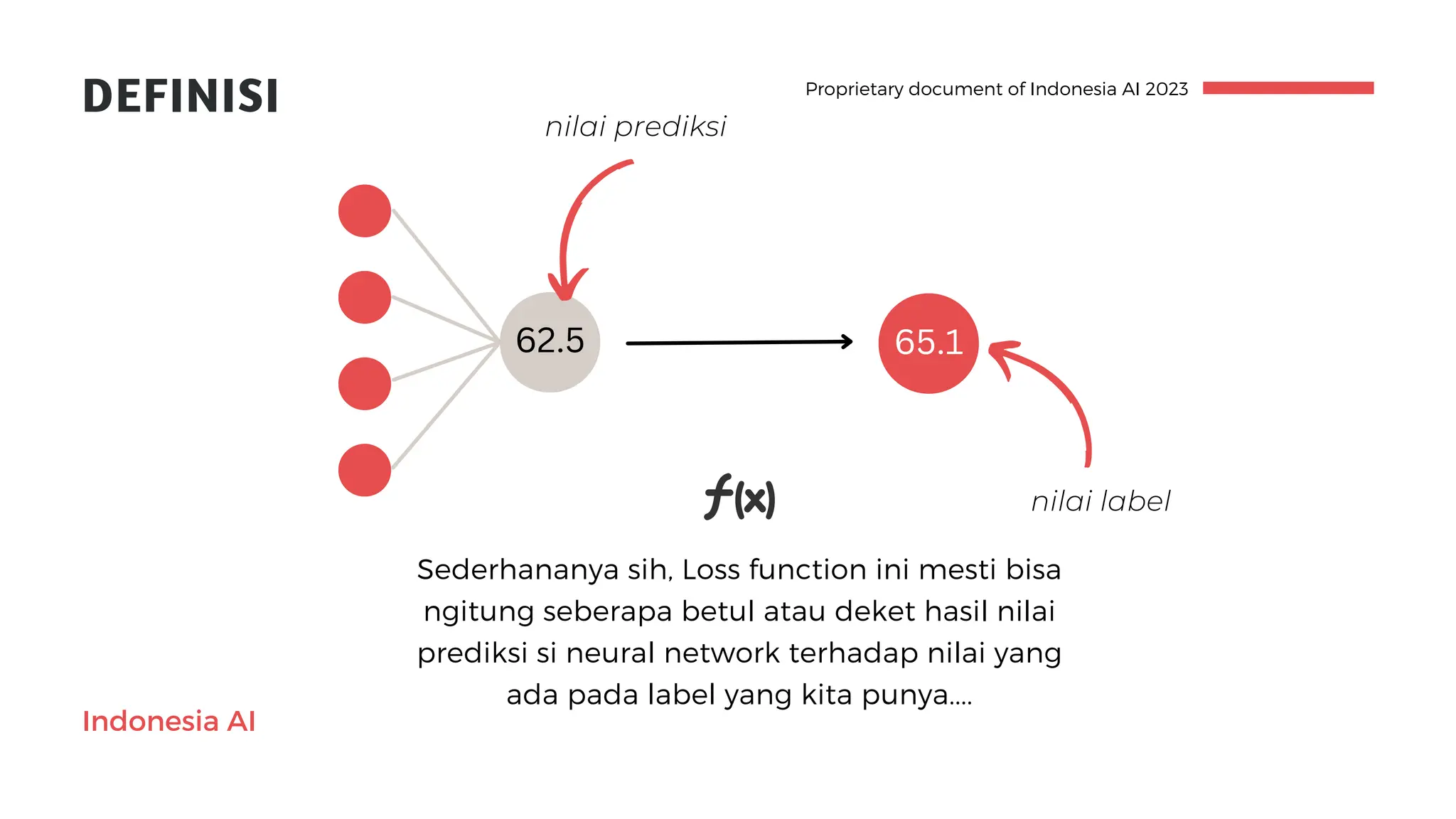

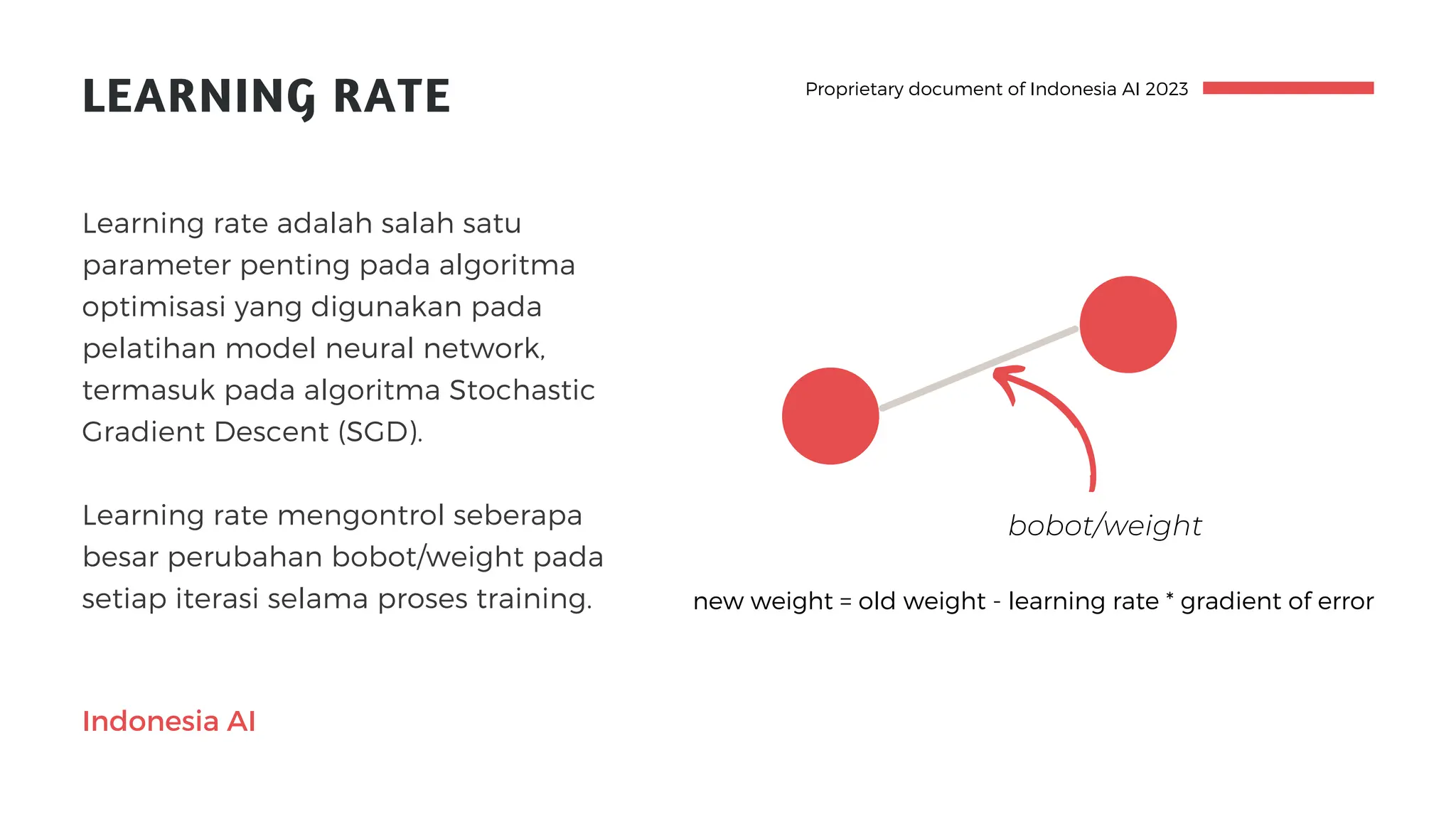

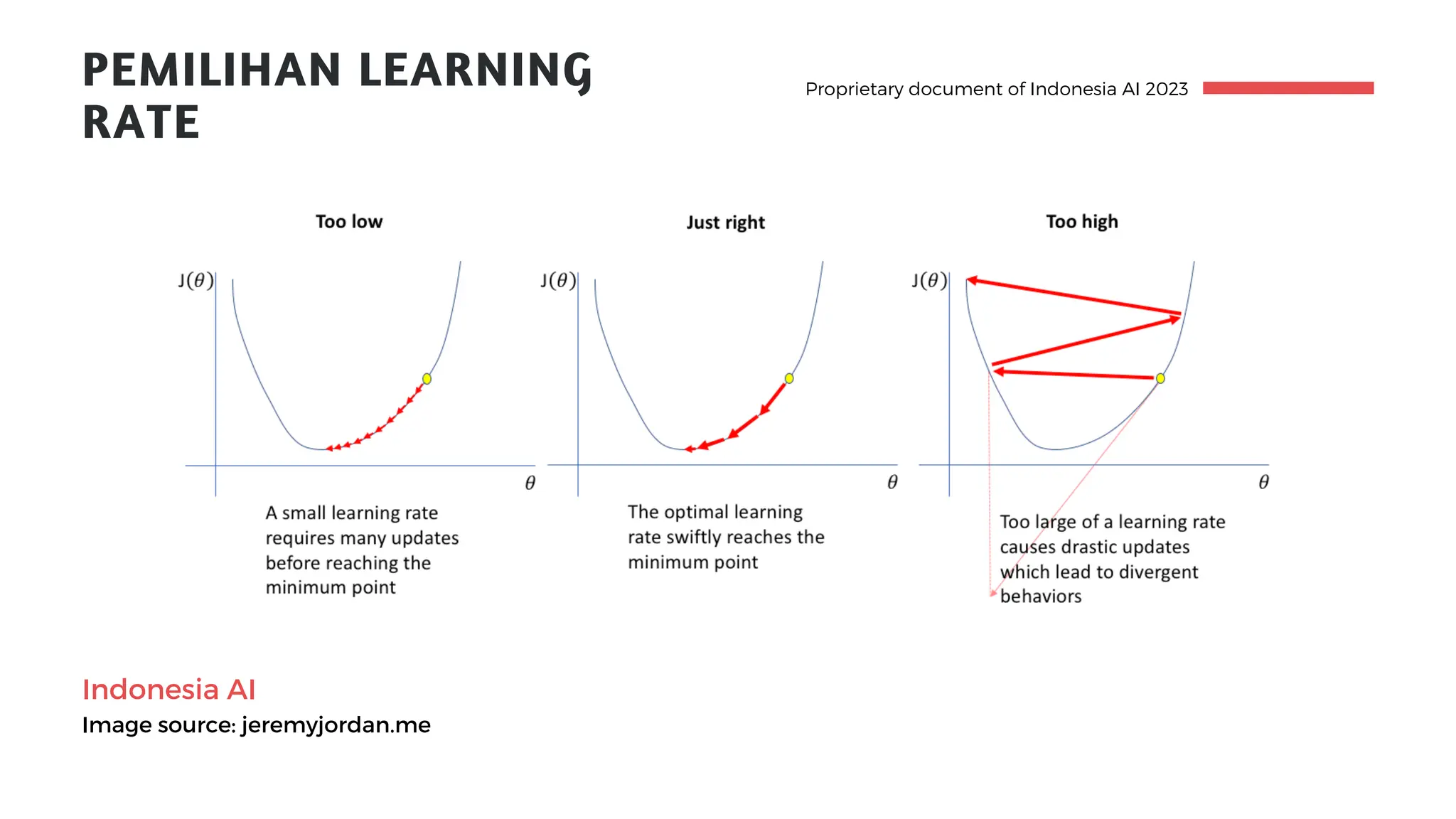

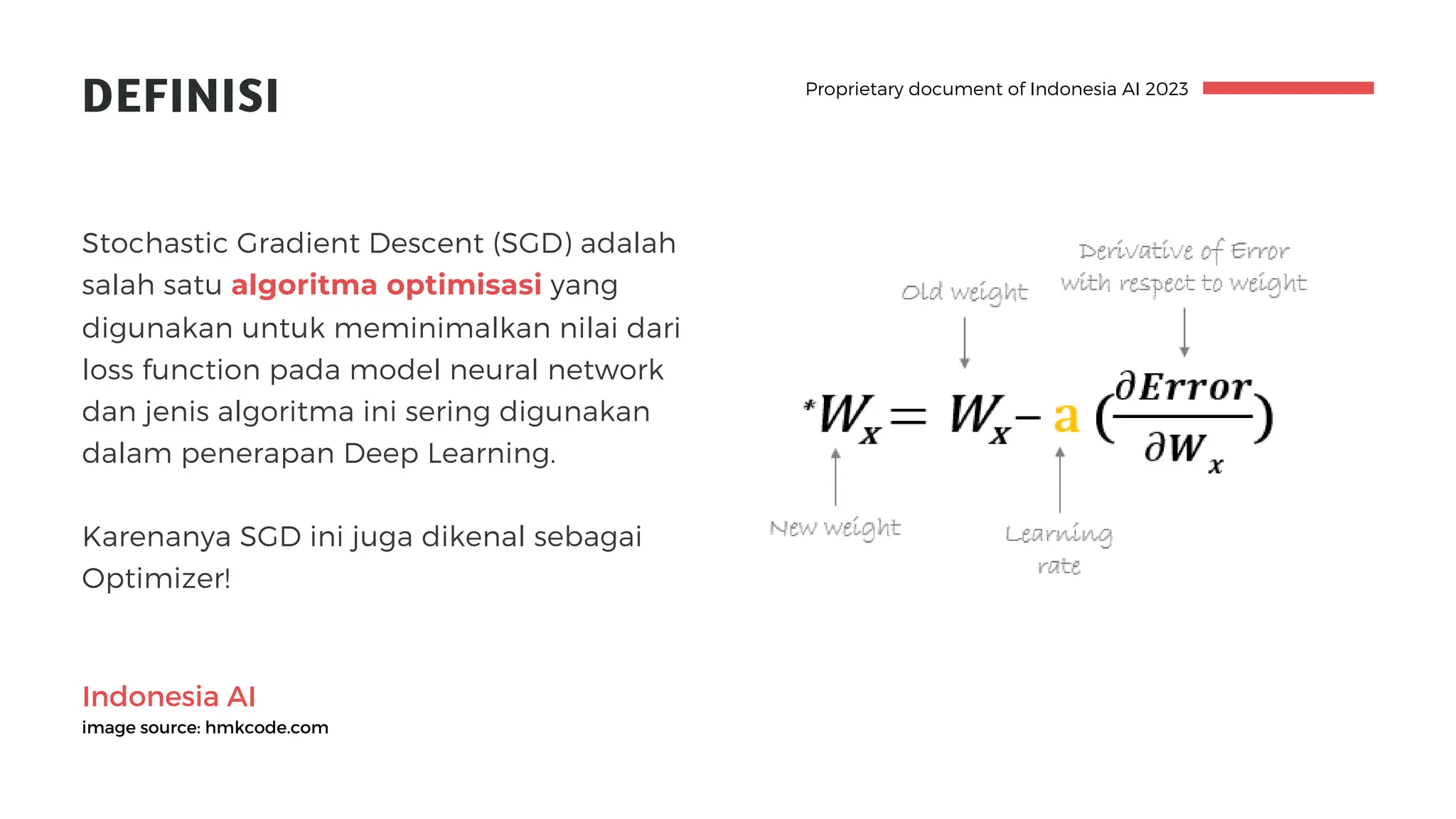

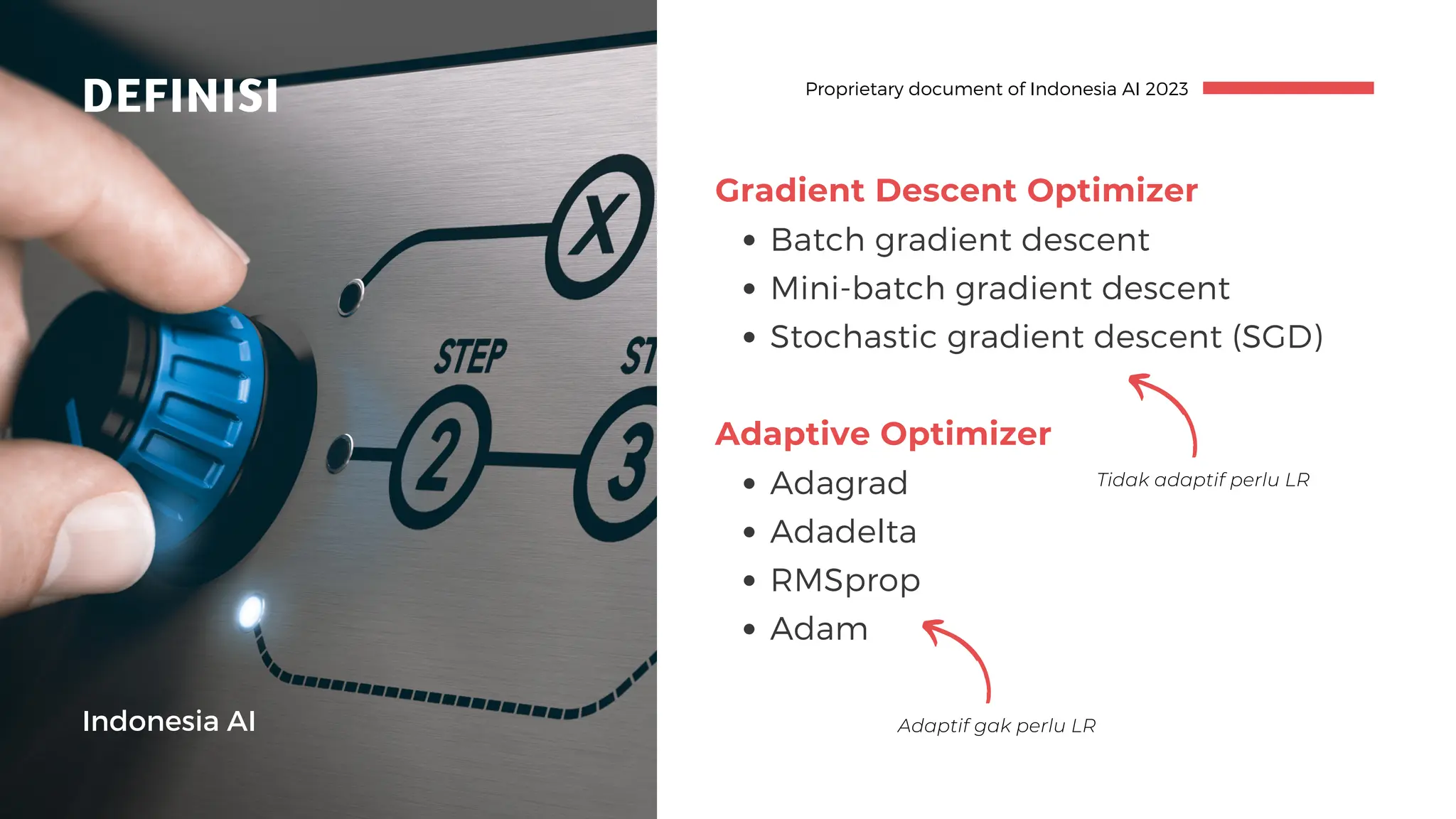

Dokumen ini menjelaskan tentang algoritma backpropagation dalam deep learning, termasuk konsep dasar, fungsi loss, dan pengaturan learning rate serta stochastic gradient descent (SGD) sebagai metode optimisasi. Proses backpropagation melibatkan perhitungan gradien kesalahan untuk memperbarui bobot dalam neural network, dan pentingnya fungsi kerugian yang diukur untuk menilai akurasi model. Selain itu, pemilihan learning rate yang tepat serta teknik optimisasi yang berbeda juga dibahas untuk meningkatkan performa model.