More Related Content

Similar to Google创新的数据中心建设方法介绍 (12)

Google创新的数据中心建设方法介绍

- 1. Google 创新的数据中心建设方法介绍

腾讯网络平台部数据中心规划组 李典林

邮箱:dufresne545@gmail.com

谷歌在过去 10 年中一直在建设自己的数据中心。搜索巨头的数据中心非常高效,利用

了可再生能源,并尽可能保护环境。目前 Google 依旧大举投资数据中心,最近三个月投资

了 16 亿美金,不得不说科技真的是第一生产力。

其实,很多年来,谷歌都有其独特的建造标准,比如说当地是否有良好的劳动力资源,

又或者有没有一个强大的电网接入能力,这可能是一个很关键的资格审核标准。最近谷歌还

增加了绿色问题考量的比重,比如说谷歌会考虑当地有没有提供可再生的能源供应的能力。

谷歌运营副总裁 Joe Kava 表示,在谷歌的理念中,长期效益不仅仅是指谷歌如何使用电

力来供应服务器,如何更快速的设计和建造数据中心同样也非常重要。他指出,位于乔治亚

州的数据中心历时 16 个月完工,而不是耗费 2 到 3 年的时间。谷歌已经建立了一整套设计

和建造数据中心的标准流程。谷歌通过模块化、低成本的设计来缩短数据中心的交付周期。

6 年前,谷歌在亚特兰大建设一处数据中心耗费了 16 个月时间。目前,在大楼建好之

后,谷歌通常只需要不到 1 年时间来完成数据中心的建设。因此除了技术领先之外,我们还

经常感叹于国外互联网公司快速的数据中心设计建设交付能力。相比之下,国内大规模数据

中心从规划设计到建成投产,整个周期往往长达 2 到 3 年。对于快速变化的互联网行业,很

多业务可能在不到一年内就爆发,或者说等机房建好之后就早已消亡,因此时间就是生命,

效率就是金钱,两三年的数据中心建设时间是不能接受的,因此非常有必要研究一下国外这

些领先公司的数据中心建设方法,以满足业务多变和快速需求的能力。本文谨以谷歌数据中

心的特点以及建设方法做些最粗浅的分析,纯属抛砖引玉,目的在于让更多同行来研究进步。

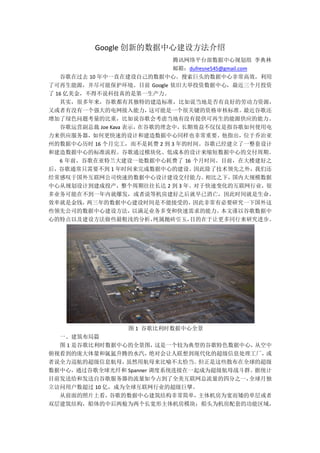

图 1 谷歌比利时数据中心全景

一、建筑布局篇

图 1 是谷歌比利时数据中心的全景图,这是一个较为典型的谷歌特色数据中心,从空中

俯视看到的庞大体量和氤氲升腾的水汽,绝对会让人联想到现代化的超级信息处理工厂,或

者说全力巡航的超级信息航母,虽然用航母来比喻不太恰当。但正是这些散布在全球的超级

数据中心,通过谷歌全球光纤和 Spanner 调度系统连接在一起成为超级航母战斗群。据统计

目前发送给和发送自谷歌服务器的流量如今占到了全美互联网总流量的四分之一,全球月独

立访问用户数超过 10 亿,成为全球互联网行业的超级巨擘。

从前面的照片上看,谷歌的数据中心建筑结构非常简单,主体机房为宽而矮的单层或者

双层建筑结构,船体的中后两舱为两个长宽形主体机房模块;船头为机房配套的功能区域,

- 4. 这里由于篇幅有限,中压部分就不再展开,但其总体思路是采用中压配电传输到机房边上,

靠近负载就近经变压器降压成低压,再通过低压母线排传输到机房内。从图 6 我们可以看到

模块化的户外型变压器及低压配电柜环绕机房周边,采用集装箱型的柴油发电机组作为变配

电的供电投切备份,柴发风管直立到屋顶上排风。经过变压器变压后的市电通过母线槽或者

线缆直连到机房内的机柜上方,直接给自带分布式 UPS 的服务器供电。

前面图 4 我们已经介绍过了谷歌的数据中心内部,母线槽是架设在机柜的顶部的,由前

面图 6 介绍的室外变压器降压后直接通过母线槽的方式架设在每排机柜顶部,再用机柜顶部

的配线盒连接到机柜 PDU。由于谷歌定制的服务器上自带有分布式小 UPS,因此谷歌的数据

中心内部不再有 UPS 室和电池室等,也没有列头柜等二次配电环节,每个服务器直接市电

直供,每个机柜也直接从机柜顶部的母线槽上安装的配线盒取电。如图 7(a)的这种供电

架构非常简单清爽,大大减少了线缆的采购和工程施工,而且非常灵活便于扩充机柜和带电

检修维护,运营起来也非常简单,还可以根据机柜的功率和用电可靠性情况灵活调整配线盒

来满足不同设备的供电需求,机房的空间利用率也非常高。

如图 7(b)所示谷歌的带小 UPS 的市电直供服务器大家都应该非常了解了,这里不再

详述只简要介绍,其原理是在服务器内安装底部的 12V 黑色铅酸电池用于市电停电保护,

市电正常时候,由于没有外部 UPS,市电直接给服务器供电,达到 99.9%的供电效率;当市

电停电后,直接挂接在 12V 输出上的电池短时放电,直至室外的柴发启动恢复服务器电源

带载。电池参与放电的时间基本不到一两分钟,因此电池的容量很小,大约只有 3.2Ah,备

电时间远远小于传统数据中心 15 到 30 分钟的电池备电需求,因此对柴发的启动要求很高。

我们前面知道谷歌的柴发是模块化直接安装在变压器旁边的,很有可能是低压柴发,其启动

很快。而且每台柴发对应一个变压器,没有复杂的柴发并机以及启动时序等问题,因此正常

情况下柴发启动时间可以控制在几十秒以内,一两分钟的电池备电时间基本上是够了,但这

对运维水平要求就非常高了。当然谷歌的软件架构和业务备份方面也足够强壮,甚至部分设

备停电也不会影响到业务正常运行,因此只有强大的技术实力才可以采用这种供电架构。

图 7(a)机柜顶部的母线及配线柜 图 7(b)谷歌的自带 UPS 服务器

前面详细分析了谷歌数据中心的供电架构,那么从建设的角度来看,由于数据中心外部

采用了工厂预制模块化的变配电和集装箱柴发单元,灵活配置按需模块化建设;而数据中心

内部,通过架设好机柜顶部吊装的母线槽,后面再根据机柜的部署进度按需安装机柜配线盒,

还可热插拔即插即用,没有复杂的线缆施工过程并大大减少线缆及配电施工质量问题,把传

- 5. 统数据中心的机电工程安装,变成了简单的工厂预制产品拼接,大大缩减了项目建设时间。

三、空调部分

前面图 3 我们简要介绍了谷歌数据中心空调系统建设过程,即采用双层钢结构框架,下

层安装储水罐,上层用于安装空调冷却塔。图 8 是典型的谷歌 chillerless 数据中心示意图,

从这个图可以清楚看到空调模块和供电模块南北一一对应,分别给机房内的对应区域供水和

供电,模块化按需建设。对于空调部分,钢结构上层的冷却塔分为两种,白色的是大型开式

蒸发冷却塔,而灰色三个并排的是闭式自然冷干冷器,分别用于不同季节的空调散热。在夏

天会采用白色的开式系统散热,冬天则采用更为节能节水的灰色闭式干冷器。钢结构下层则

为多个白色的储水罐,用于储存冷却塔散热后的冷却水,兼作为市电停电或者冷机重启阶段

用的储水池,保证持续供冷。储水罐两侧还有散热水泵和板换等,后者用于机房内的冷冻水

和机房外的冷却水换热。在此机房的右下角还有两个冷却塔系统专用的柴发,用于给这些冷

却塔系统做掉电保护,和储水罐一起配合来确保数据中心持续供冷。

图 8 谷歌某个数据中心空调系统示意图

谷歌的目标是使用尽可能少的能源来为谷歌的产品提供动力,因此能不用机械制冷的冷

水机组就尽量不用,而谷歌的高效冷却塔系统就是在这方面所做的努力的典型。在北欧的几

个数据中心都实现了无冷水机组机房的设计和应用,但在一些夏季比较炎热的地区,谷歌还

是建设了冷水机组,以防温度或湿度过高情况下无法只依靠冷却塔来排热。谷歌只在万不得

已的时候才使用这些装置,一年中大部分时间都是靠板式换热器散热,尽量不开启冷机。

图 9 谷歌数据中心大型冷水机组系统

- 6. 如图 9 所示的采用大型冷水机组的数据中心内,谷歌也是采用了模块化的建设思路。图

10 中在机房建设的初期,一次性建设好空调水系统的大型环网主干管路, 并采用隔离阀将

这些主干管路在多个机房模块间隔离分区,避免新建模块机房的管路影响到已投产机房模块。

大型主干管路上预留有一个个的冷却模块接入阀门,以及连接到机房内部的多个水平支管。

每组冷却模块和水平支管对应一定排数的服务器机柜,比如可以覆盖 4-5 长排的机柜排等,

不断按需扩容建设冷却模块和水平支管等。每个冷却模块都是模块化建设,包含冷水机组、

冷却塔、换热器、阀门系统、水泵和配电单元等,且新增冷却模块对原有系统影响很小。

图 10 谷歌数据中心主干管路的模块化扩展建设

在快速建设方面,谷歌创新的空调系统建设模式总结下来有三个特点,第一个是在机房

建设初期采用租赁设备的模式尽快让机房投入生产,在此同时建设剩余的永久性固定部分,

等机房全部建成后租赁的设备退还给设备租赁公司;第二个是初期采用风冷冷水机组或者混

合式冷却塔等设备,无需冗长审批申请流程,快速让机房投入生产,再滚动建设永久性部分;

第三个是模块化的空调子系统可以不断地增加并投入使用,且建设过程中的增加空调子模块

不会对已经投产的部分系统有较大影响,这几个特点大大加快了谷歌数据中心建设进程。

图 11 是某个数据中心建设的早期平面图,其中冷却模块 148 是租赁来的小容量冷却模

块,而 145 则是永久性安装的大型自购冷却模块。154 是主供水管,而 156 是主回水管,截

至阀 144 允许冷却模块 145 从整个空调系统中独立开来。类似的,租赁的小冷却模块 148

也通过接头 150 连接到整个空调系统中,并可由截至阀 146 从空调系统中独立开来。通常租

赁的冷却模块 148 要比自购永久性冷却模块 145 的尺寸和制冷容量都要小一些,比如方便采

用标准卡车方便拖运到现场,通过软接头等方式快速连接到空调主管路中提供额外的冷量,

也容易从主系统中拆卸和退租。这里补充说明一下冷却模块 145 还是 N+1 系统的+1 备用冗

余模块。

图 7 租赁空调系统和永久性空调系统的安装示意

- 7. 数据中心建设的初期,租赁来的小冷却模块 148 投入建设并调试,同时还在机房内建设

好机柜及置顶空调等,然后再和冷却模块 148 一起经过测试验证环节,快速投入生产。由于

冷却模块 148 的制冷能力有限,以及随着 IT 负载不断增加的上架量,永久性的冷却模块 145

就需要被建设,但此时截至阀 144 仍处于关闭状态,不接到整个系统中。当 145 永久性冷却

模块完成建设,则通过 144 截至阀连接到整个系统中,并经过测试验证后投入使用。随着负

载的不断增加,新的 IT 机柜以及新的冷却模块不断被建设测试验证投入使用。

除了空调系统外,供电系统也可以采用类似的租赁方式快速满足早期的供电需求,比如

图 11 左下角的临时租赁供电模块 152 用于数据中心早期的负荷,随着负载的不断增加,永

久型的供电基础设施也被不断建设并测试验证投入使用。

四、机房内机柜建设模式

谷歌数据中心内部的建设也是模块化按需堆叠的模式来建设。图 12 是谷歌北卡数据中

心的内部实景,可以看到顶部是一排排的母线排,以及模块化热插拔配线柜;中间是模块化

的置顶空调,以及空调顶部的线缆桥架托盘;下面则是封闭的热通道框架,以及模块化的三

联柜安装泊位。具体每个变压器覆盖的母线排数量可根据每排机柜总功率密度有所调整,且

由于每排机柜内的供电和散热自成一体,排与排之间解耦,因此机房内不可以以机柜排为颗

粒度不断建设扩容。

图 12 谷歌北卡数据中心内部实景

图 13(a)是每排机柜的截面图,从这个图可以看到谷歌热通道及机柜的布局。热通道

框架内为空调盘管及散热风扇,热通道框架两侧三联柜机柜直接锁固在空调框架上,整个构

成 6 个 IT 机柜的微模块基本单元,并以此微模块颗粒度不断复制。IT 机柜及空调都从顶部

的母线排取电,整个机房大环境为冷通道,热通道内热气流自动上升,被置顶空调降温后自

然回流到机柜前面再次被服务器吸入,整个气流路径很短,且冷热隔离,散热效率非常高。

图 13(b)是数据中心内部新建设微模块置顶空调建设示意,新建一排机柜时,可通过

隔离帘子 725 隔离待建设部分和已投产部分,避免建设粉尘对已投产机房的影响。可通过叉

车将置顶空调及支撑框架以模块化方式在现场快速组装,这些串联的空调单元组成一个封闭

热通道,两侧形成两排机柜泊位等待 IT 设备到场安装。

- 8. 图 13(a)谷歌微模块的截面图 图 13(b)置顶空调建设过程

我们知道谷歌数据中心的机柜颗粒度是三联柜整机柜,如图 14(a)所示,顶部还有 IT

机柜配线盒从供电母线排取电。这些三联柜机柜根据业务的不同配置,在服务器工厂以整机

柜的形式安装好服务器及网络,并连接好内部供电及网络线缆,运送到机房现场内后以图

14(b)的三联柜方式由现场建设人员推动安装到机柜泊位上,连接好供电和光纤线缆,即

插即用,快速投产。

图 14(a)谷歌三联柜机柜 图 13(b)三联柜安装示意

图 15 则是谷歌数据中心内部置顶空调机房建设过程中的局部照片,机房内部一排排支

撑架上是其封闭热通道顶部的置顶空调,架空地板下走水,而机柜上方是母线排,并通过软

管连接好冷冻水,与供电系统和冷冻水系统测试验证完毕之后等待整机柜交付。

通过前面的这些机柜排之间解耦,空调置顶微模块、模块化配电盒、三联柜等标准化建

设单元,工厂预制,现场快速拼装,达到数据中心内部的快速建设目的。

- 10. 及管道等可以从当地租用,数据中心场地可以是刚平整好的荒地、或者是水泥和沥青的平台

和停车场等,也可以是货物仓储等建筑。模块化计算存储单元 820/825 被运输到现场,可移

动的柴油发电机组 840 也被安装在现场,通过供电线缆 870 连接到 820/825 的 IT 模块上。

同样的,制冷散热单元 850(内含隔离换热器,也可能包括制冷机组或者混合式冷却塔等)

也通过管路 872 和 873 连接到 820/825 的 IT 模块上,用于给 IT 模块来散热。而制冷单元 850

则通过供水管 874 从供水单元 830 获得水补给。经过一段时间的运行后冷却塔的冷却水会有

沙子沉淀以及产生化合物沉积甚至军团菌等微生物污染等,因此部分冷却水从 876 水管排放

到污水回收单元 835 槽罐车内,再运送到污水处理厂处理。

此外,快速部署数据中心还包括光纤 878 以及网络进出口 860,也可以是偏远地区的无

线发射接收装置,还有监控管理单元等,这里不再一一罗列。甚至整个快速部署数据中心可

以建设在污水处理厂旁边,直接从污水处理厂处理后的清洁水来给数据中心散热,然后排放

的污水直接再次处理等。同样的,快速部署数据中心也可以直接建设在供电或者发电站旁边,

不再设置供电模块等。

六、总结

模块化建设思路是大规模数据中心的一个重要特点,可以大大提升数据中心的建设进度。

图 16 是传统数据中心和模块化数据中心(非谷歌数据中心)的项目进度表比较,可以看到,

通过模块化的建设思路,大大节约了规划设计时间,将原来工程化数据中心的串行建设模式,

变成并行建设的标准化建设模式,大大节约了项目时间,并且有很好的可复制性。

图 16 传统工程化数据中心和模块化数据中心的对比

本文简单梳理了谷歌的数据中心建设模型,如图 17 简要示意,从园区建筑的单层简单

框架式大开间结构,两翼供电、制冷模块化快速安装,到建筑内模块化机房分期建设,再到

机房模块内的微模块级复制堆叠,以及微模块内即插即用部署的三联柜整机柜最小颗粒度。

这种逐级模块化思路,大大简化了规划设计和机电建设,将传统工程化的数据中心建设模式

大部分转变成产品化堆叠方式,大大节约了传统模式下串行开展的时间。同时标准化模块可

复制性强,可以快速复制到新的建设项目中,避免了传统工程化数据中心各种独特的设计。

通过这些解构可以看到 google 把数据中心进一步拆分和简化,如同把大型 DC 变成了一个个