2022年4月22日POL共催セミナーでの講演資料です。

https://peatix.com/event/3202191

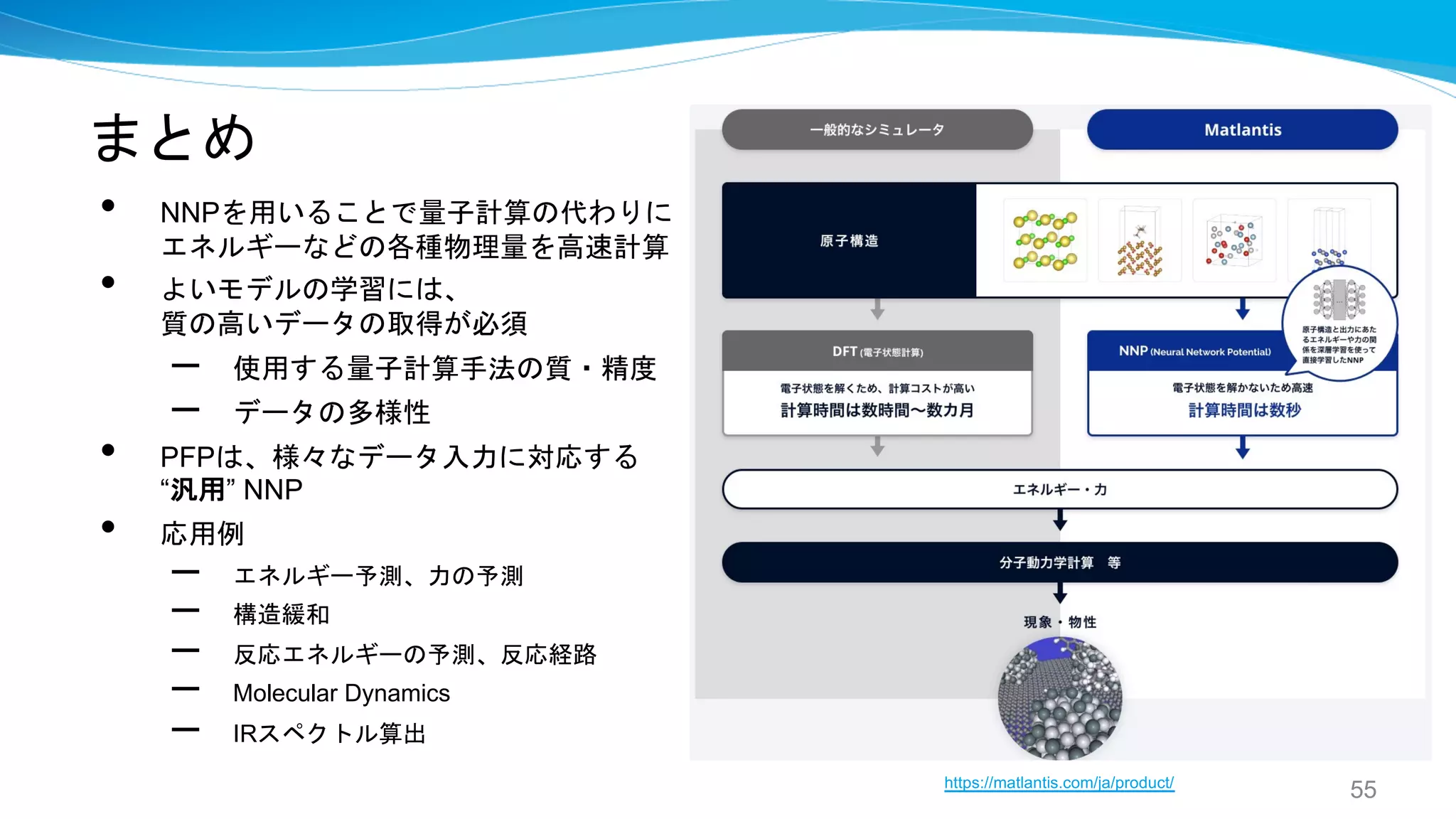

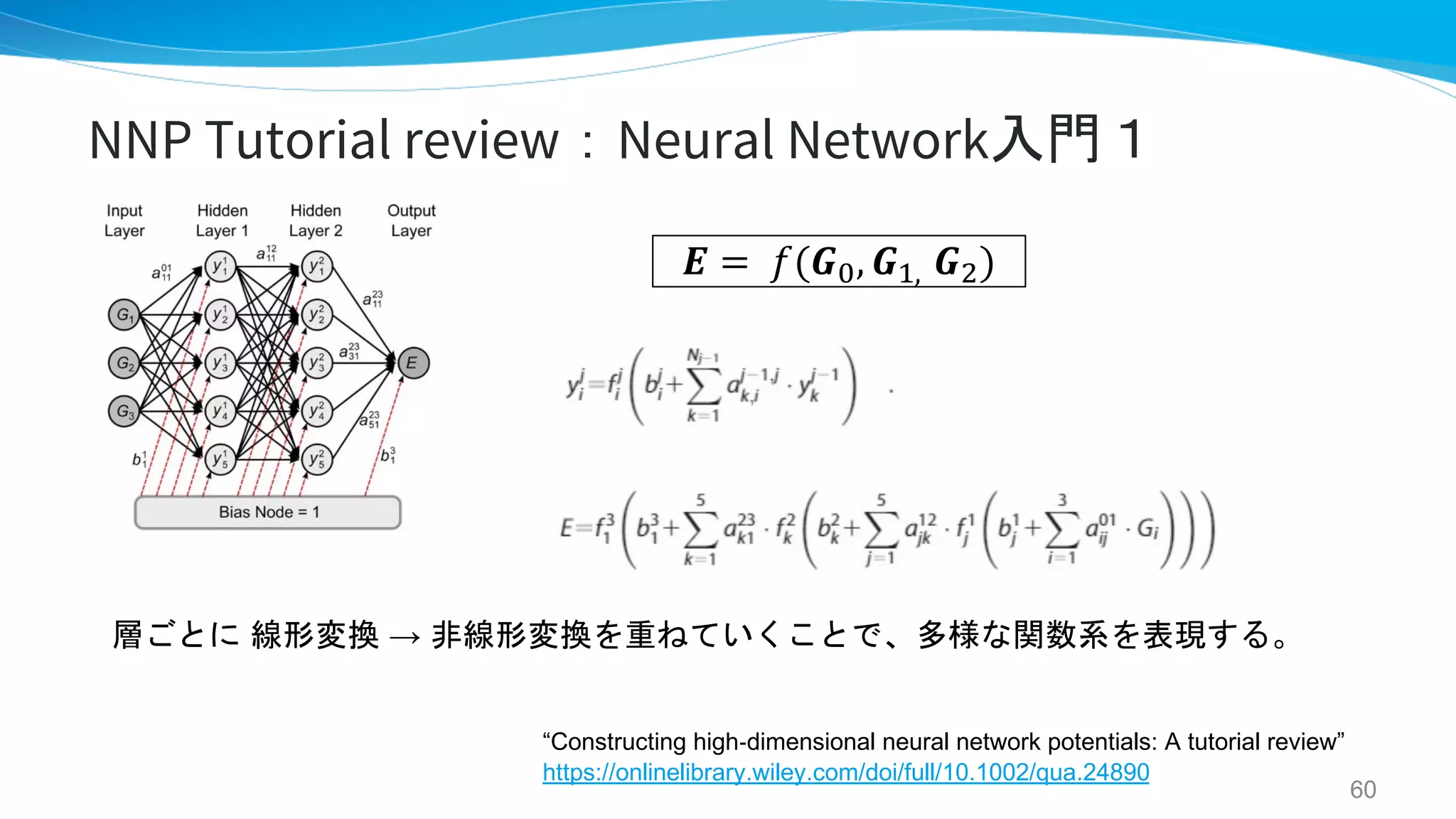

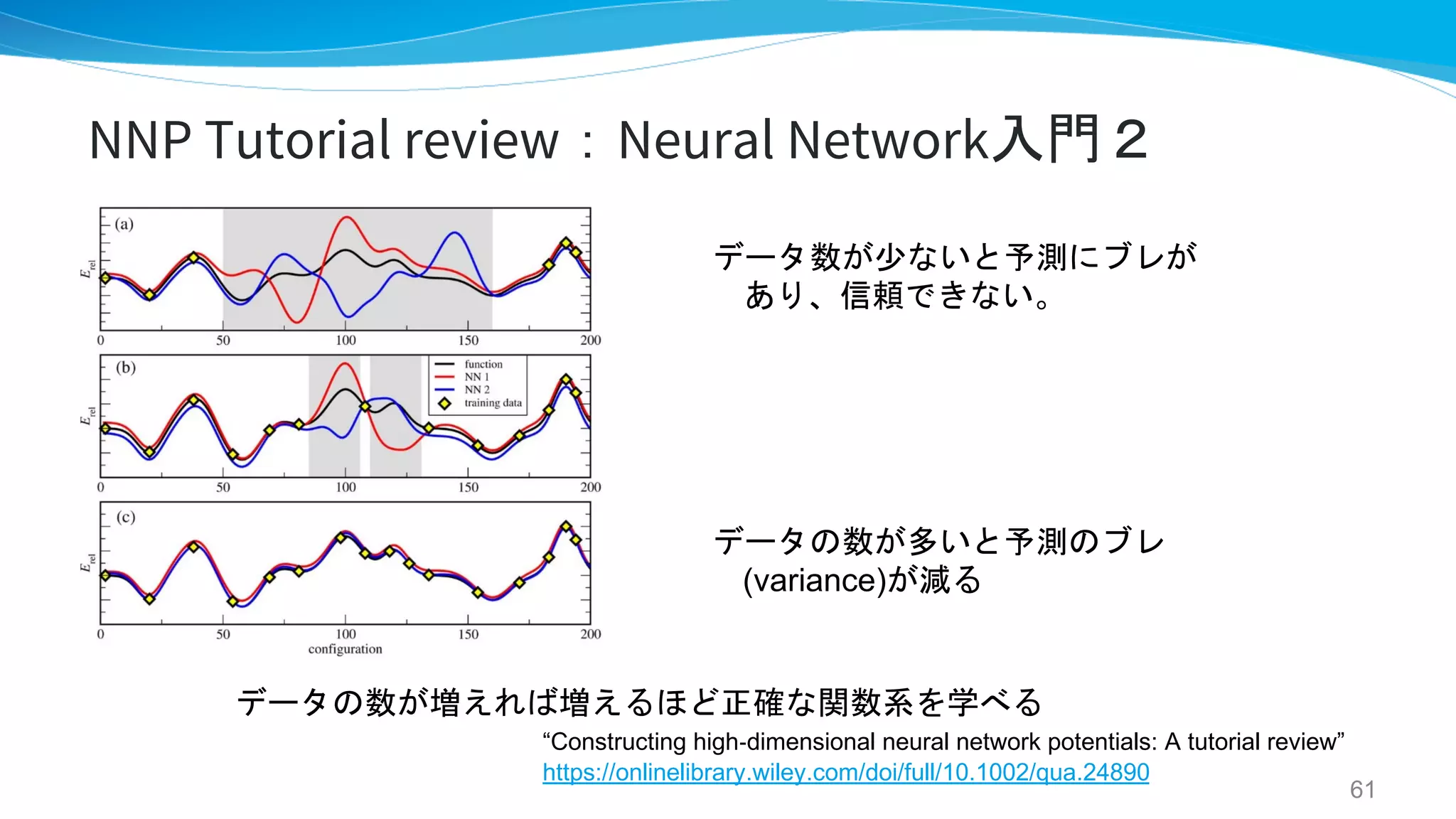

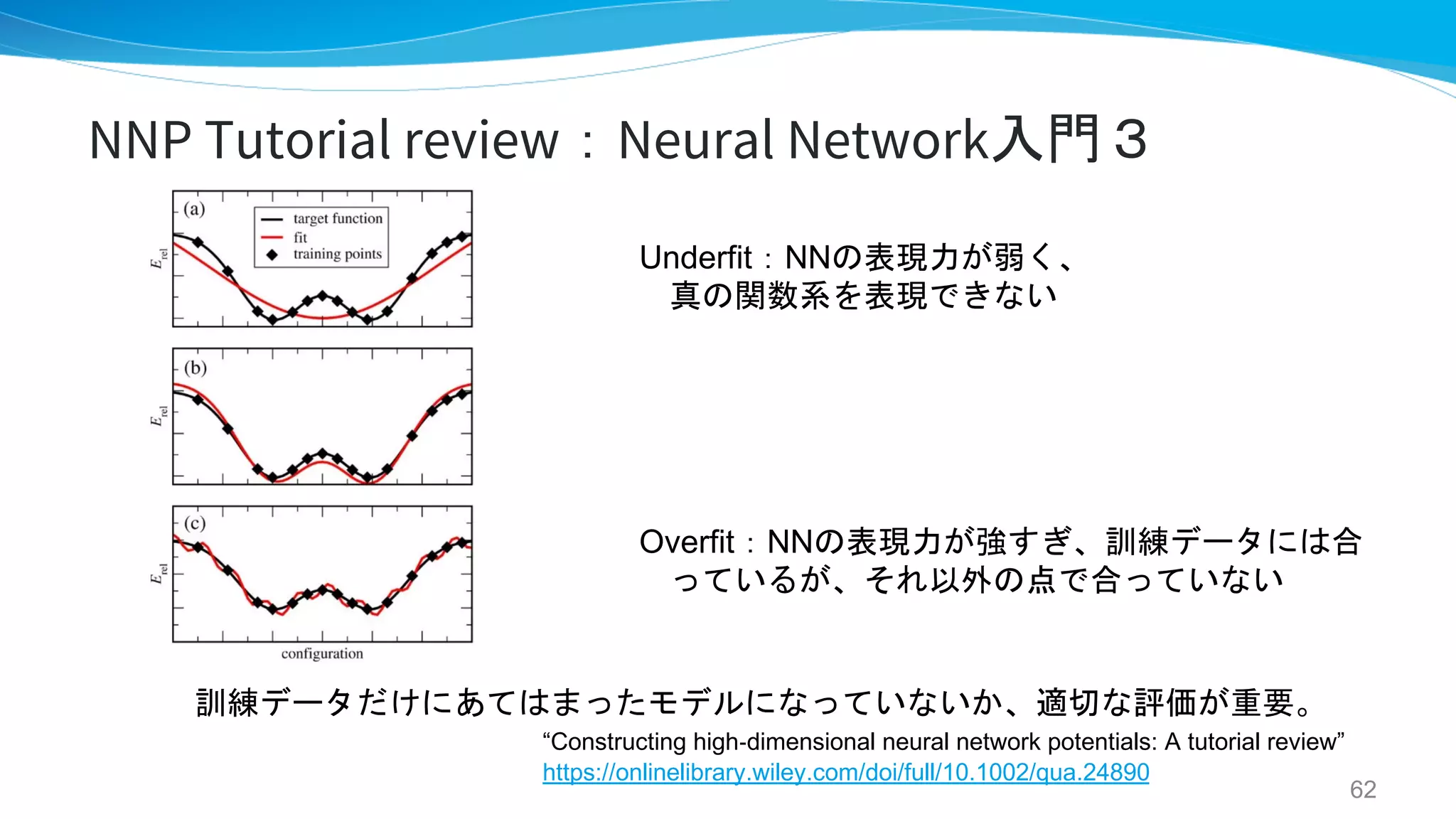

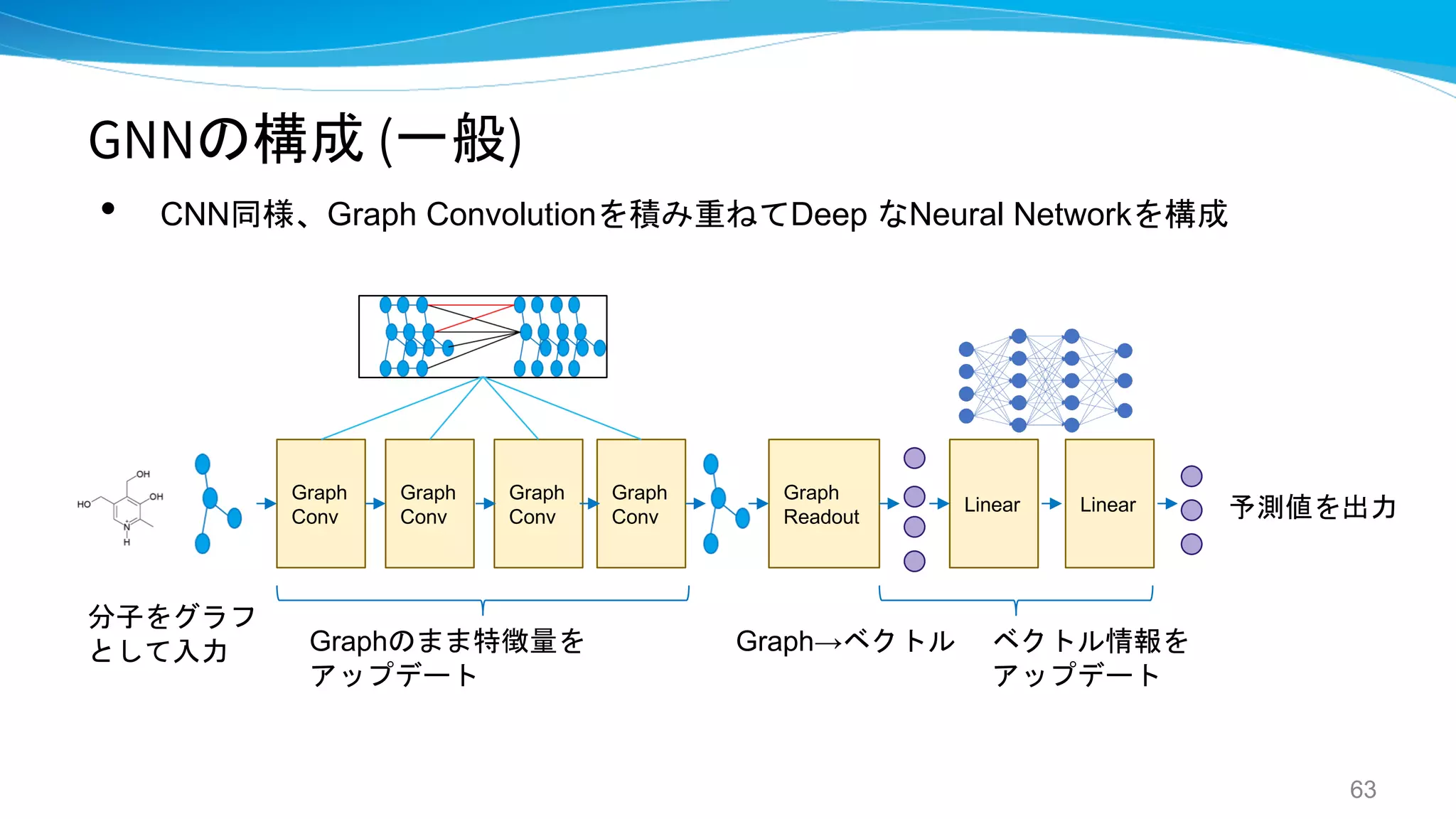

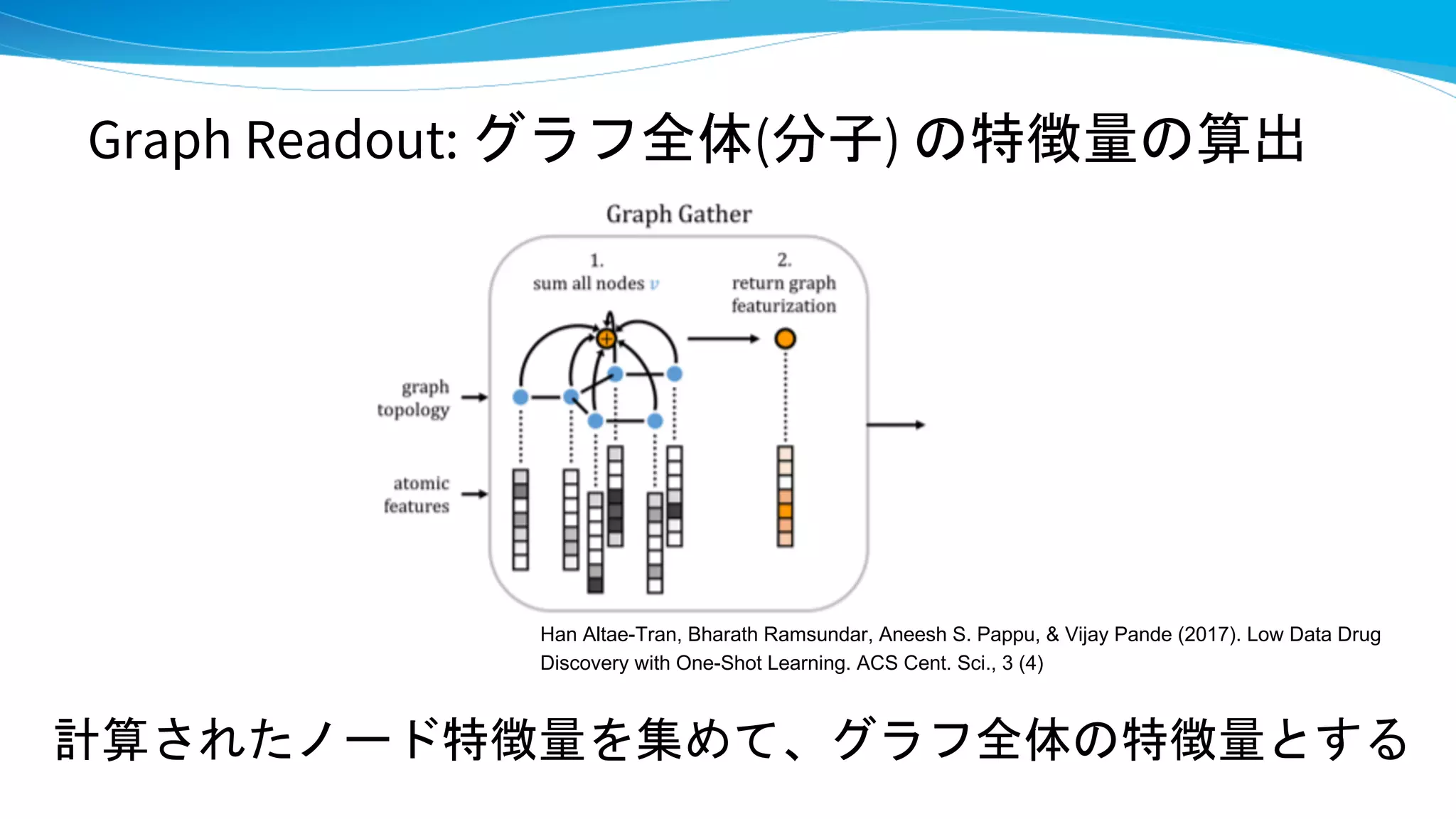

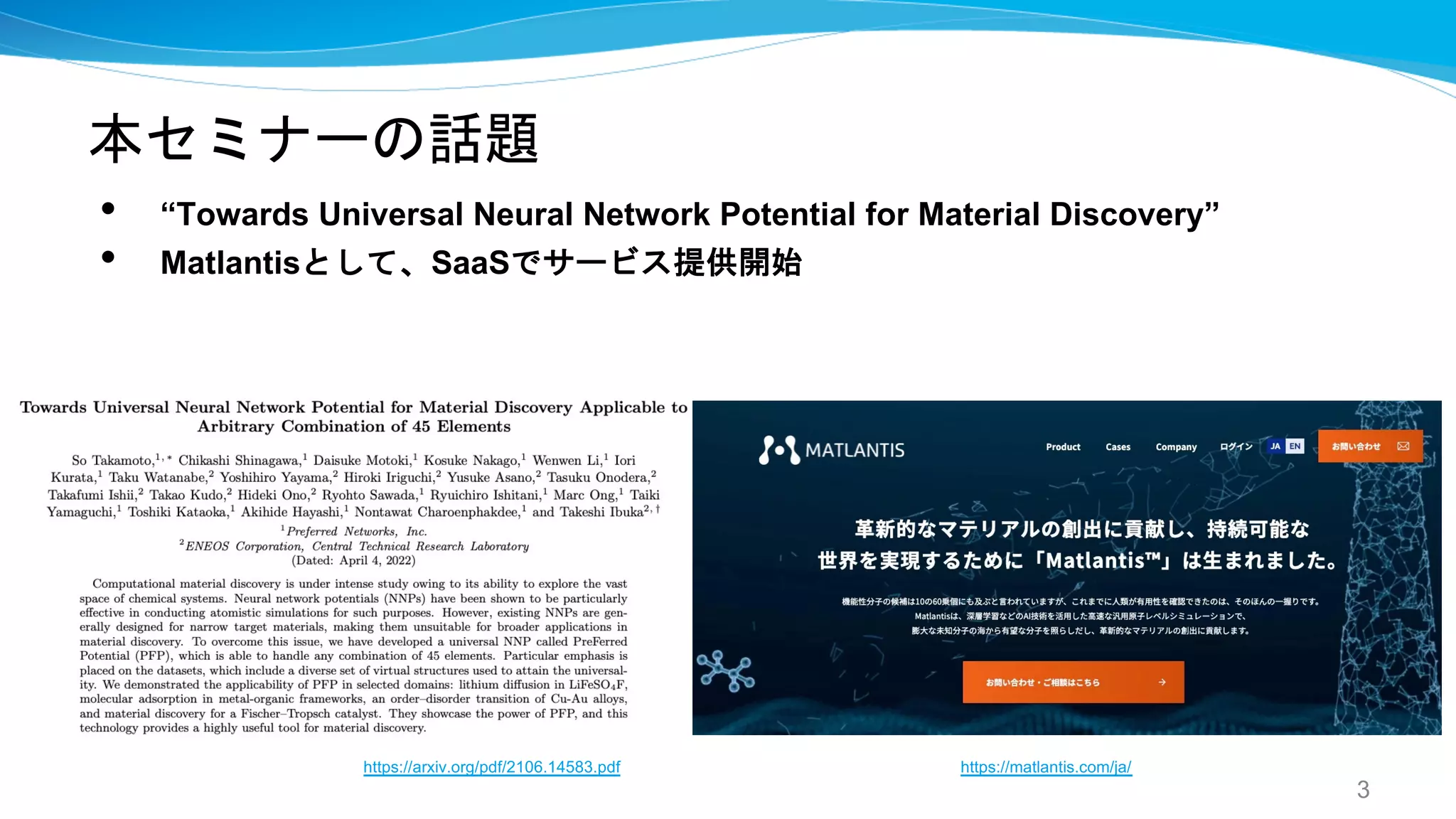

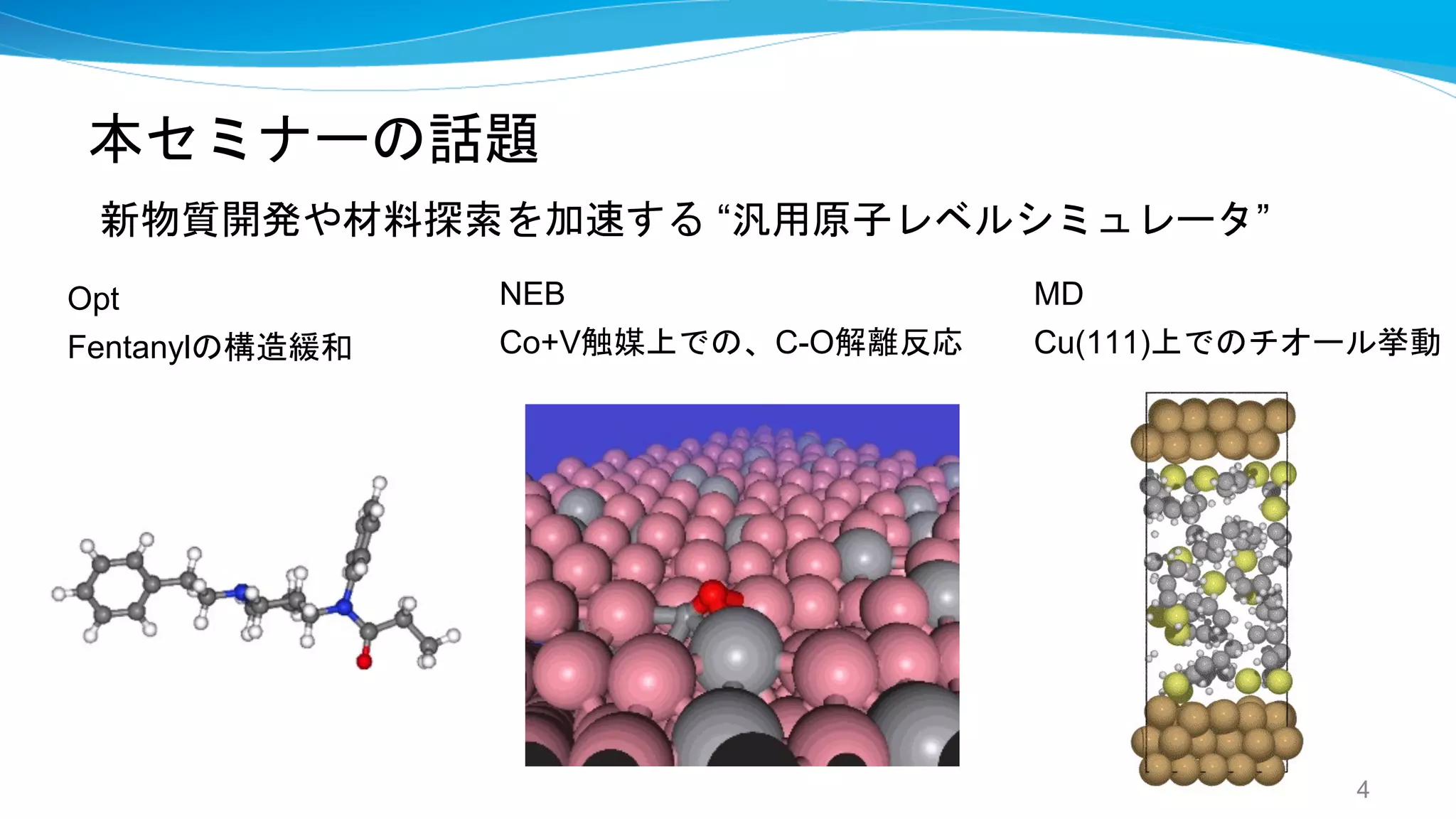

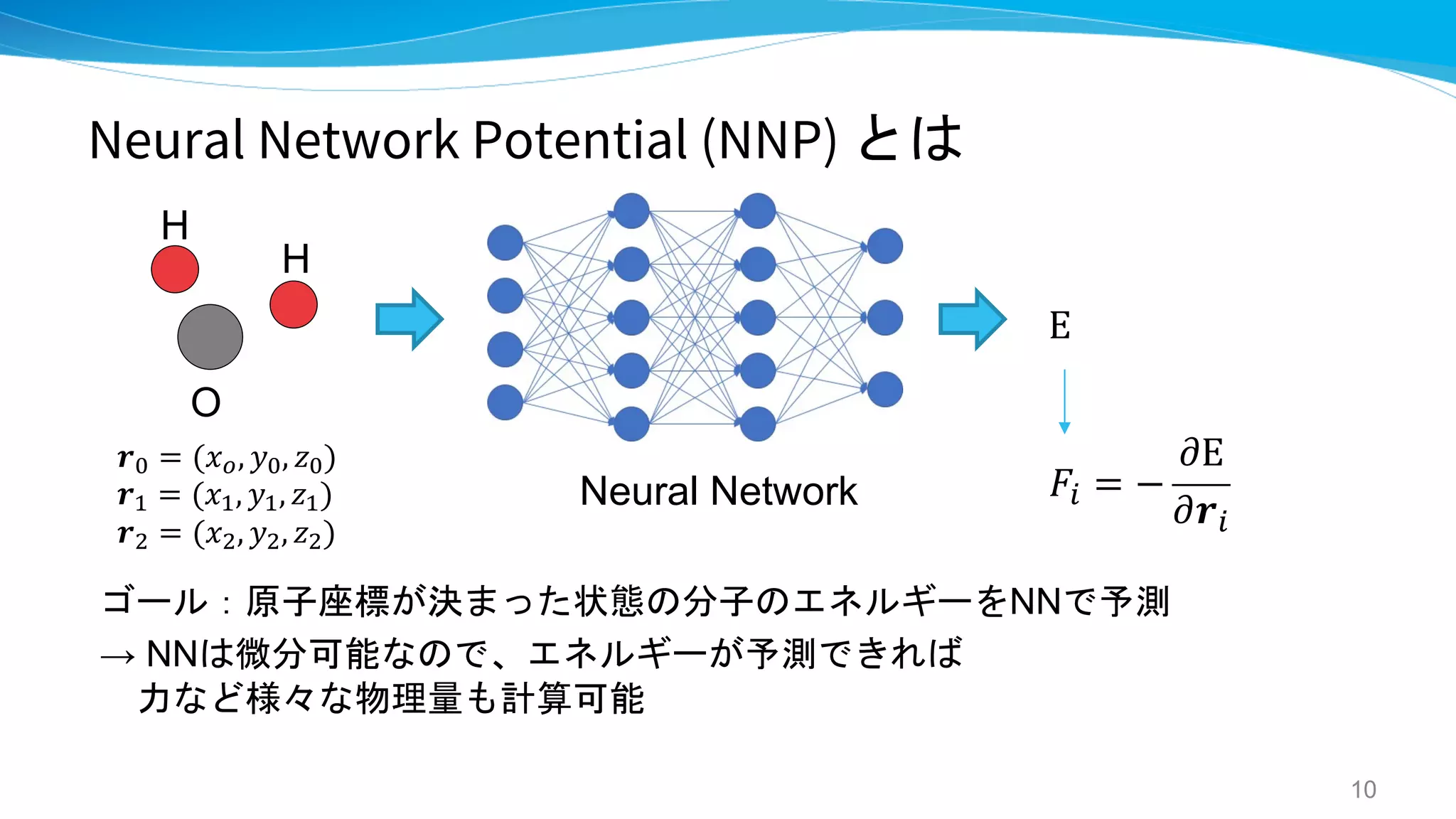

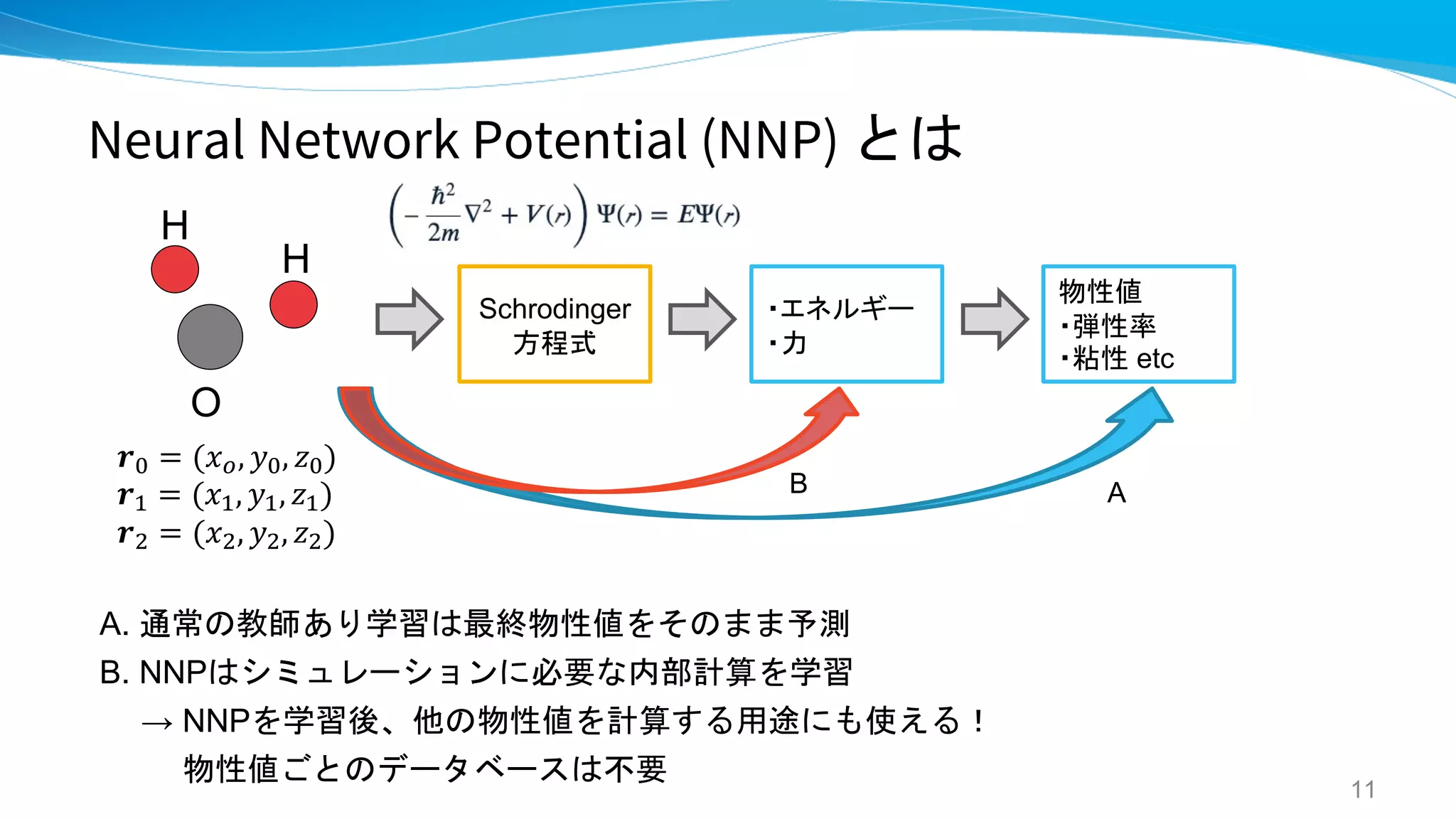

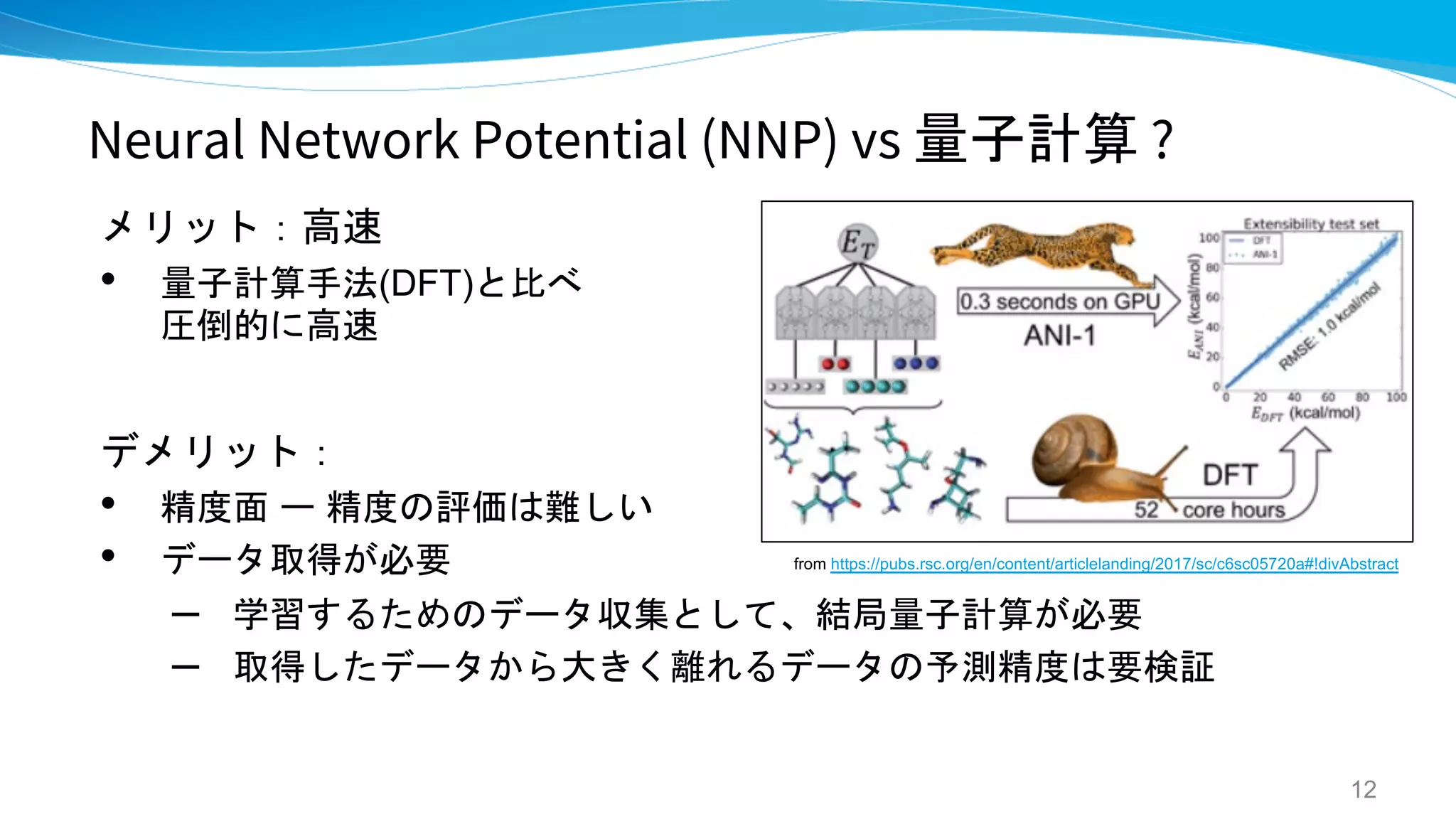

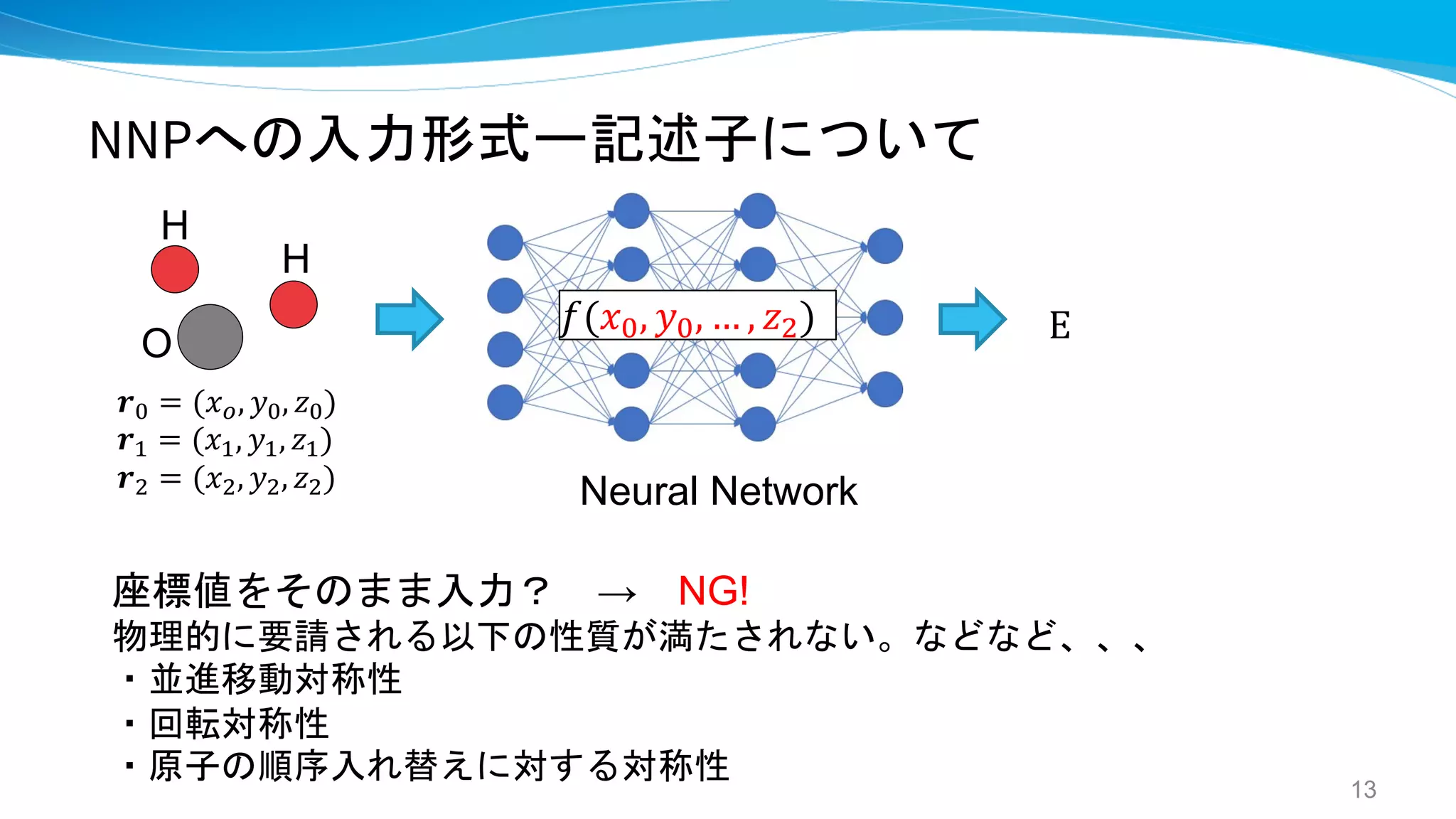

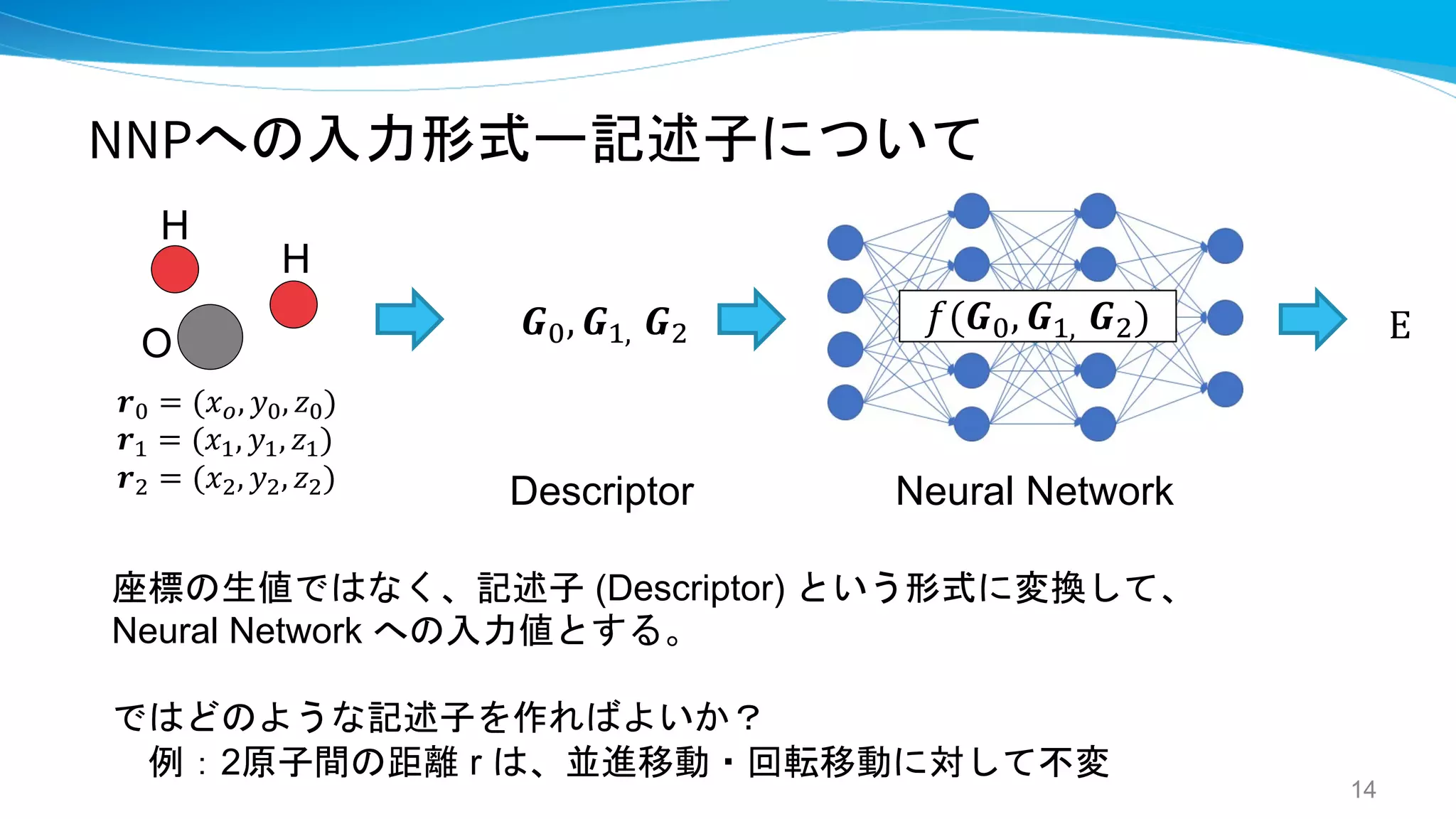

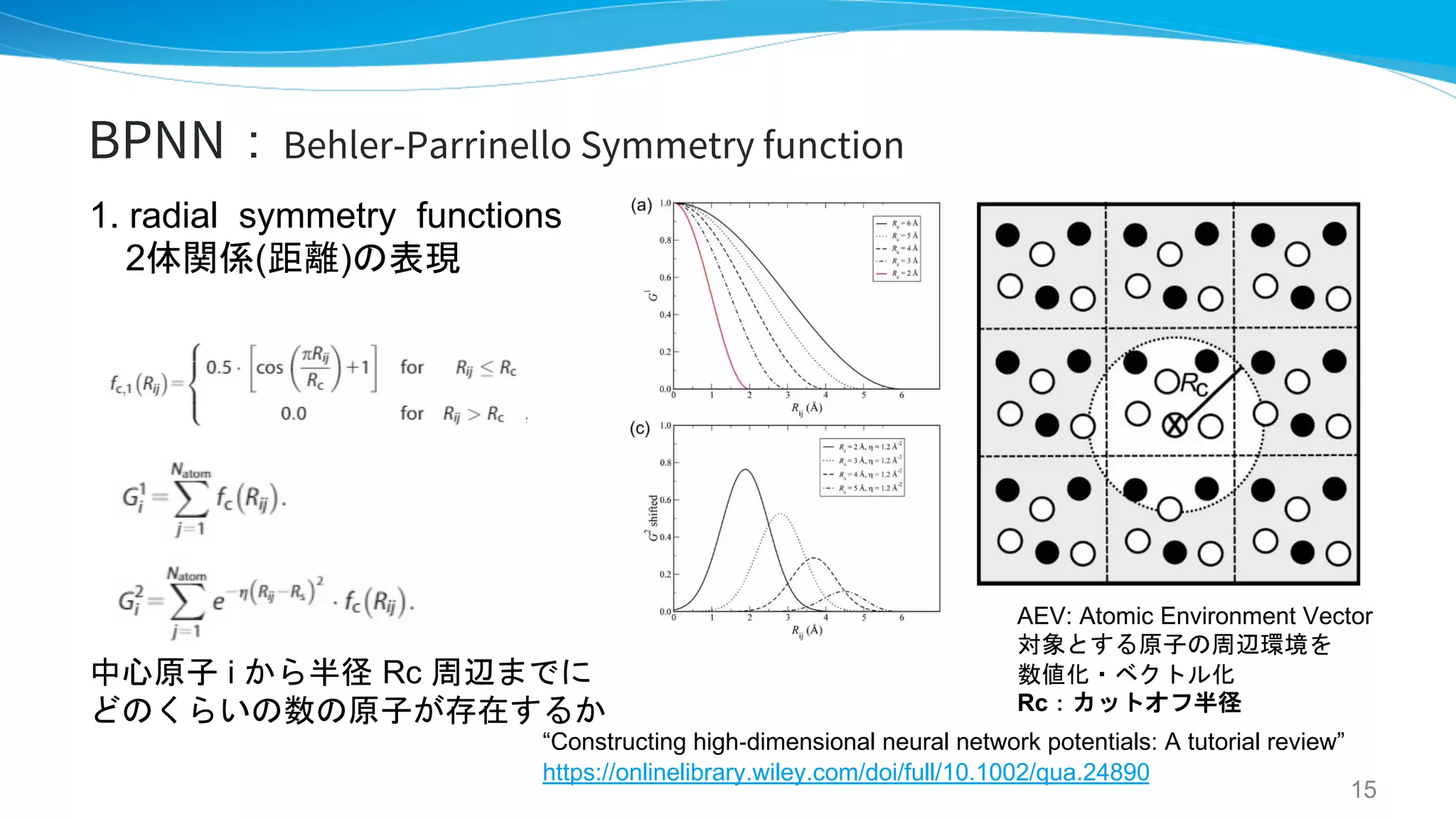

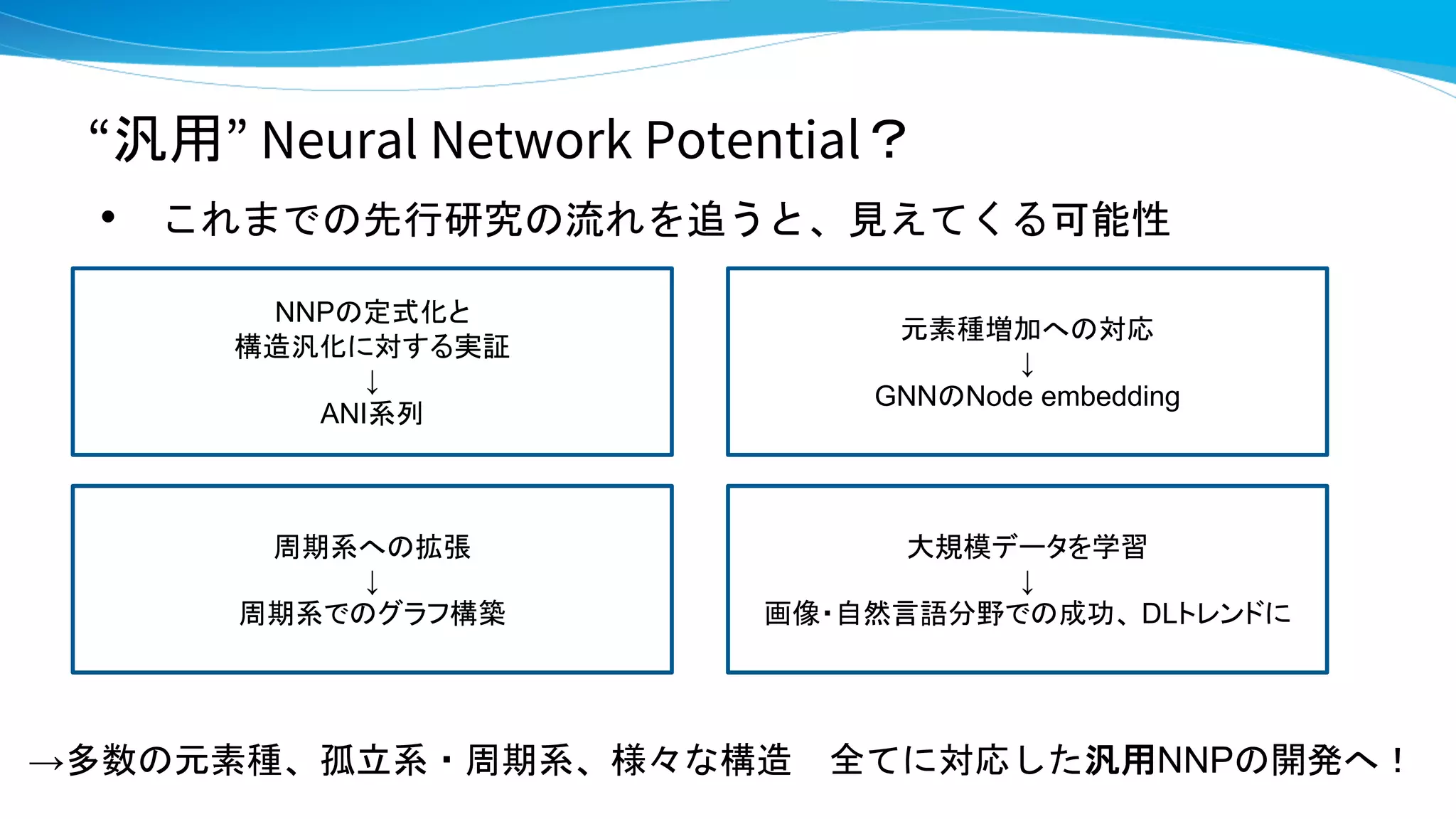

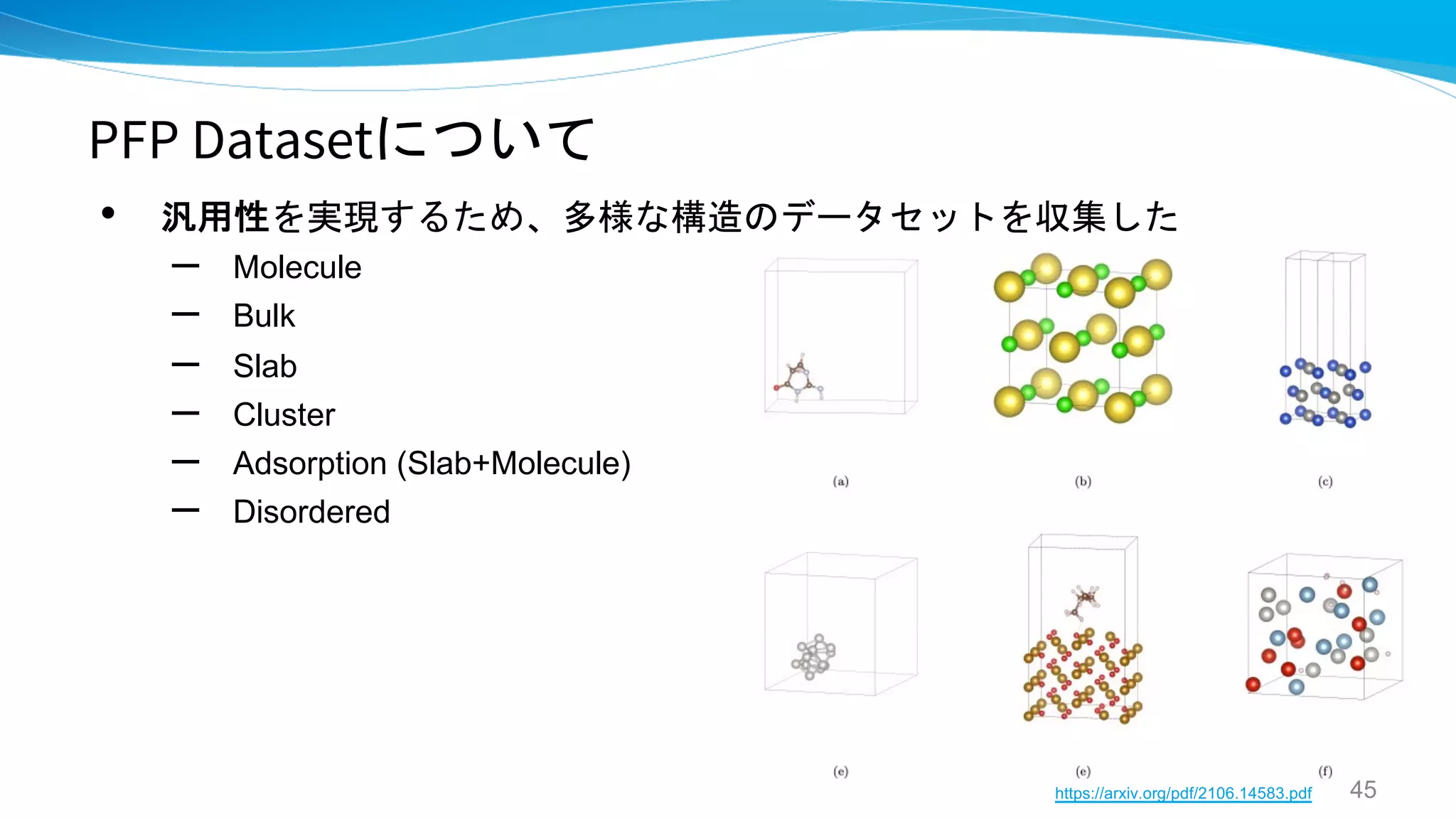

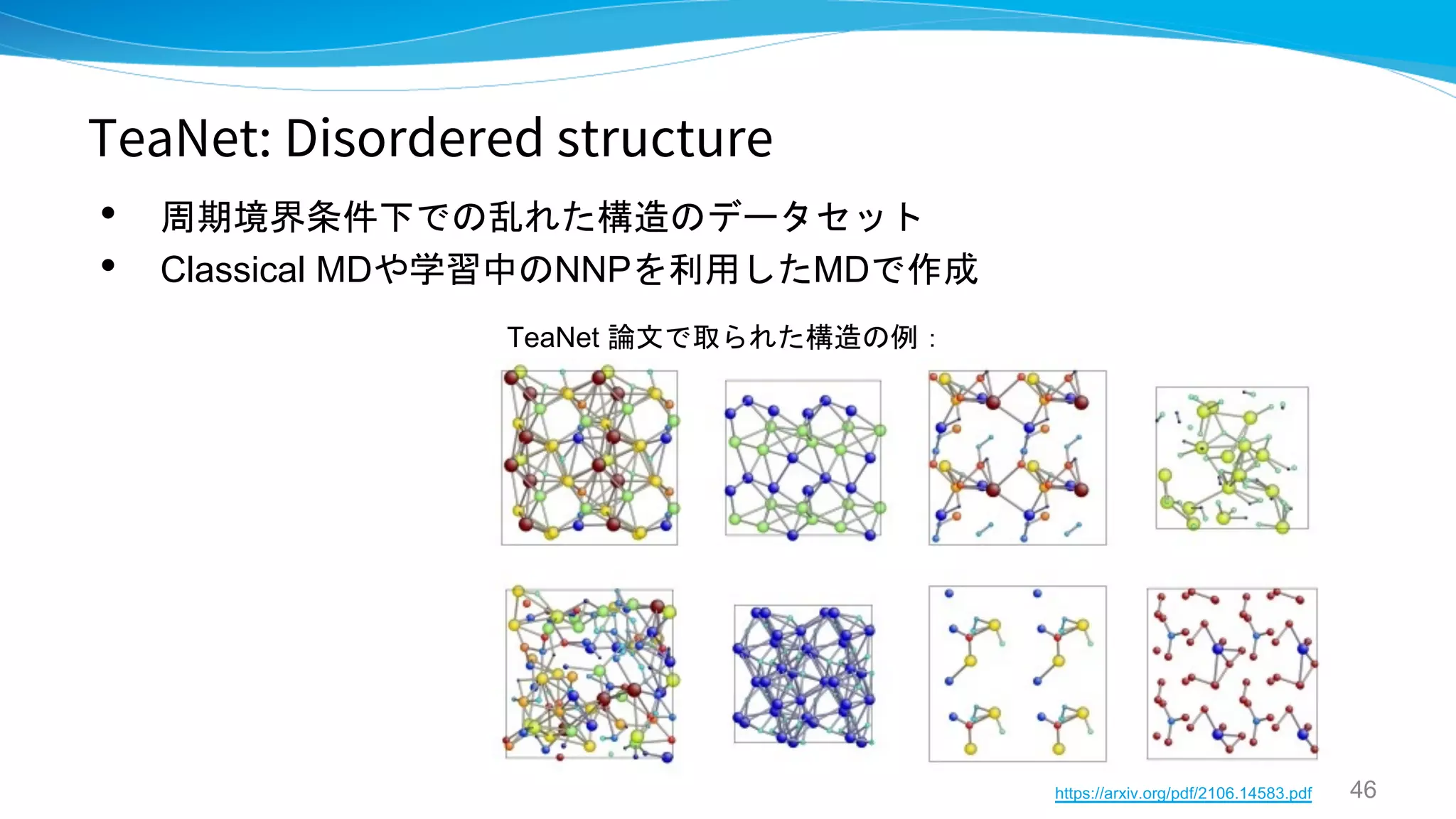

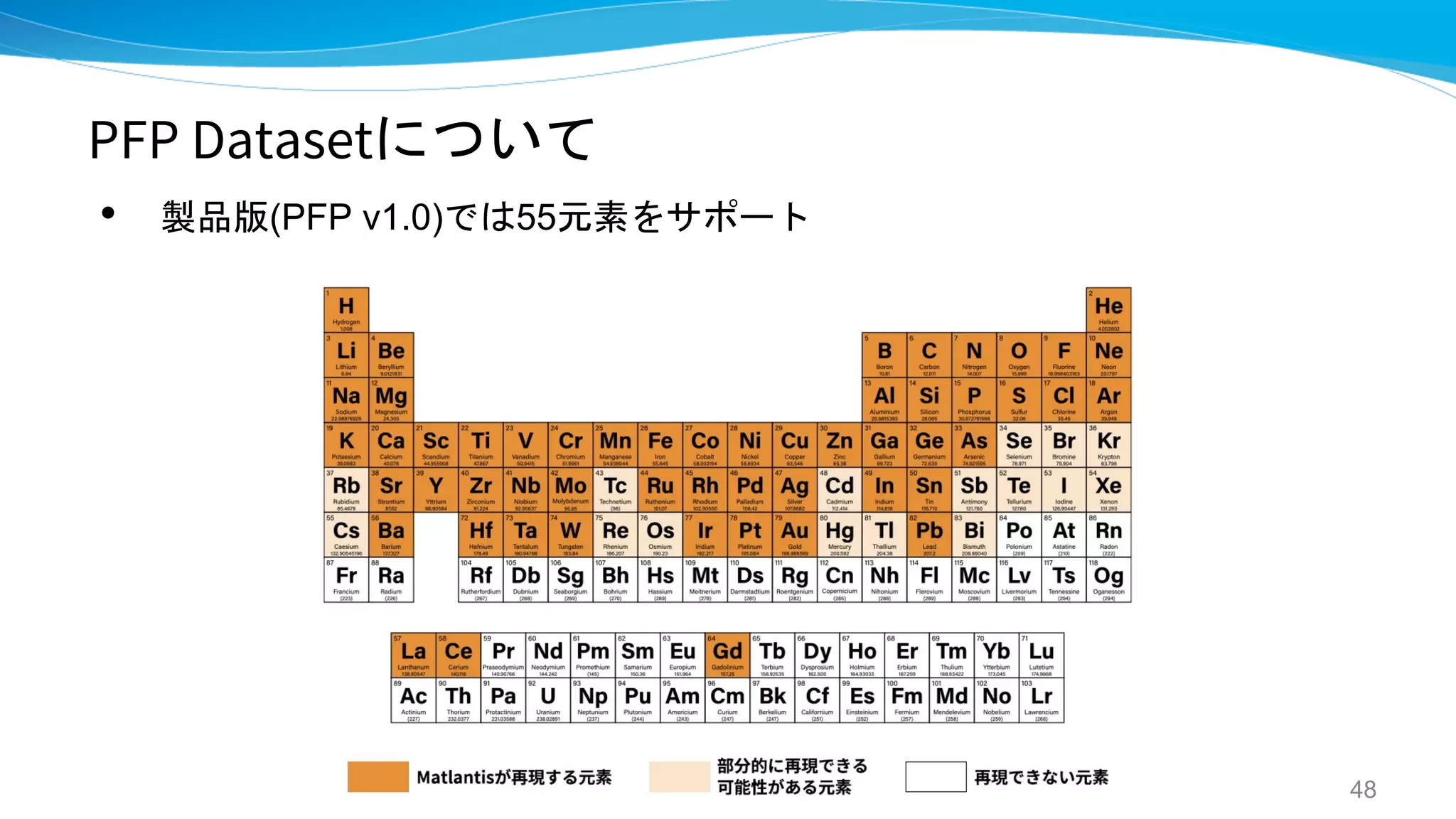

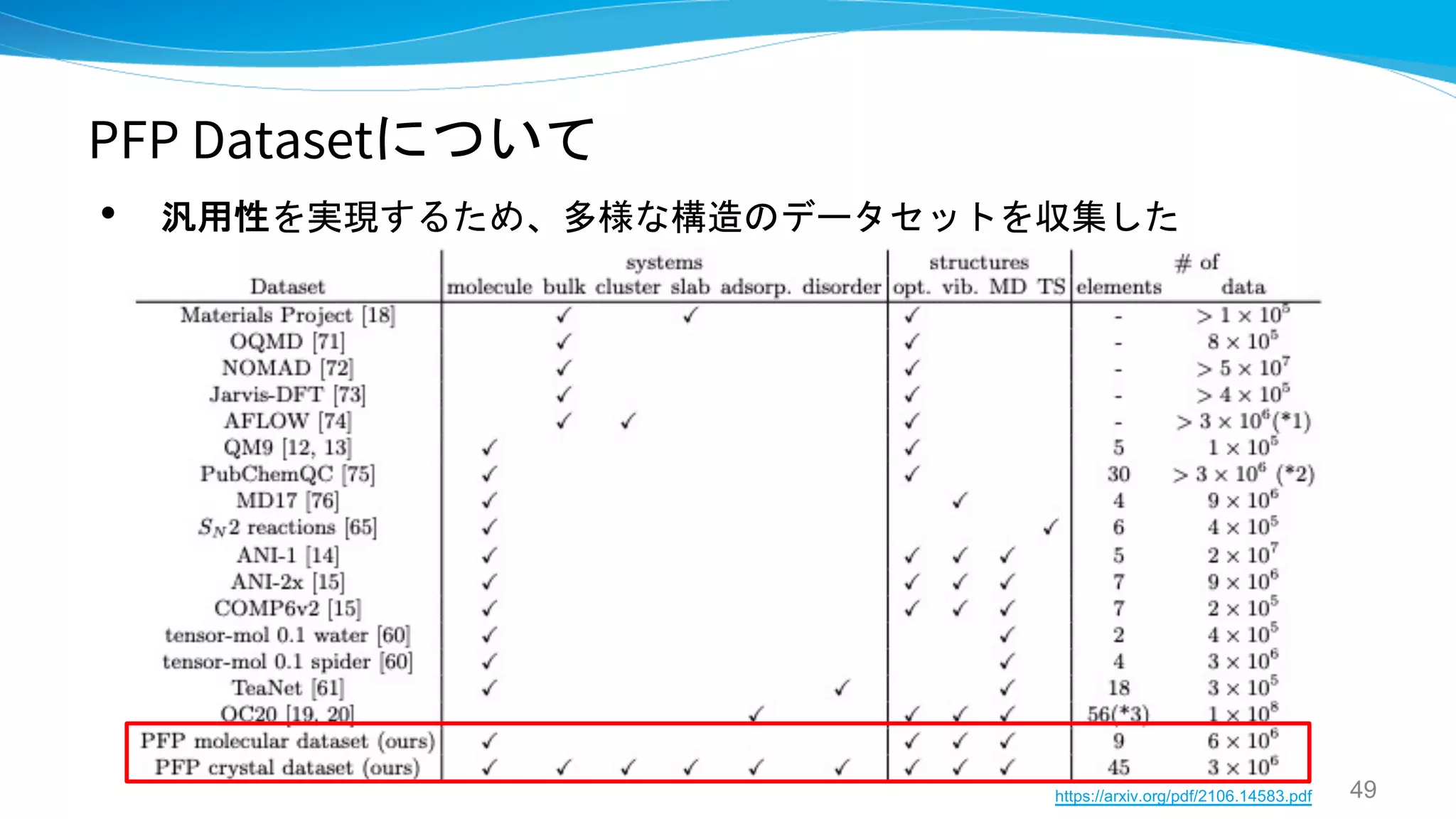

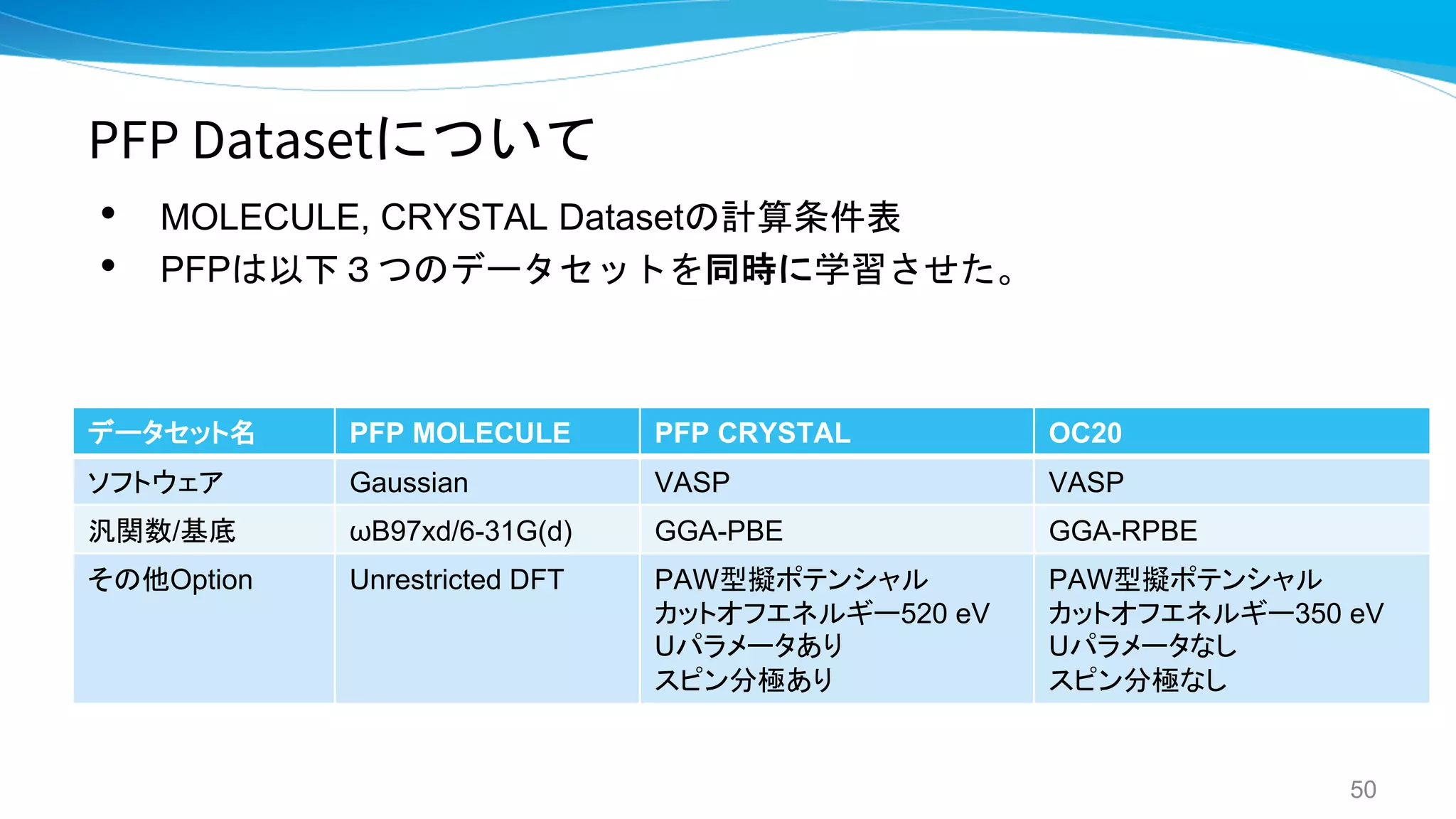

本資料の前半では、NNP研究の流れを振り返り、どのようにNNP開発のためのデータセット収集やNeural Networkの取扱いが発展してきたのかを紹介

しています。そして後半では、多種多様な系に対して適用可能となるように開発した汎用NNPであるPFPについての解説を行っております。また、PFPを用いた事例としてどのような材料探索が行えるかをその応用的な使い方とともに紹介しております。

Preferred Computational Chemistryウェブサイト

https://matlantis.com/ja/

Preferred Computational Chemistryツイッターアカウント

https://twitter.com/matlantis_pfcc

![PFPについて

• TeaNet をベースにして、2年間の研究開発のなかで

いろいろと拡張(論文参照)

• GNNの辺を張る際のCutoff は6A

– 5層でそれぞれ、[3, 3, 4, 6, 6]のカットオフ

– →全体で22Aの受容野は確保

– 現状、GNN部分はO(N)になるように設計されている

• エネルギー局面がなめらか (無限回微分可能 ) になるように設計

43](https://image.slidesharecdn.com/pfpneuralnetworkpotential20220422pol-220425035554/75/PFP-Neural-Network-Potential_-_20220422POL-43-2048.jpg)

![適用事例1: Liイオン電池

• LiFeSO4Fの各方向におけるLi拡散活性化エネルギー計算

– 様々な元素が混じる系

– おおむねDFTを再現

51

[111], [101], [100] 方向への拡散経路](https://image.slidesharecdn.com/pfpneuralnetworkpotential20220422pol-220425035554/75/PFP-Neural-Network-Potential_-_20220422POL-51-2048.jpg)