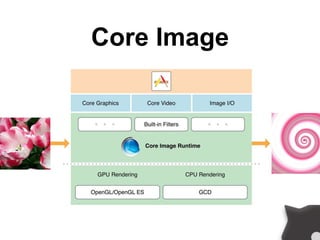

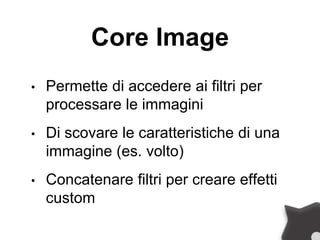

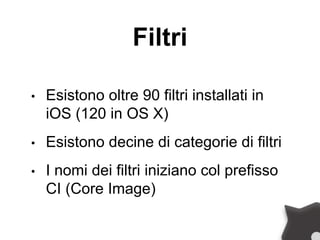

Il documento descrive le tecnologie core image e avfoundation per lo sviluppo di applicazioni iOS, evidenziando le funzionalità di elaborazione delle immagini e dei video. Viene esaminato l'uso di filtri, il rilevamento delle caratteristiche facciali e la gestione delle sessioni di acquisizione audio e video. Infine, il documento menziona anche la condivisione dei contenuti tramite UIActivityViewController.

![[DEMO]](https://image.slidesharecdn.com/mokapp2014-danielegaliotto-140626124558-phpapp02/85/Mokapp2014-Daniele-Galiotto-Camera-e-sorrisi-14-320.jpg)

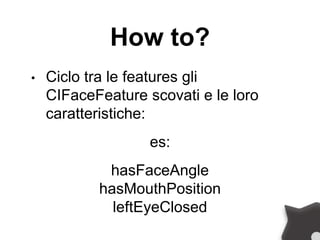

![How to?

• Avvio la ricerca delle caratteristiche

nella immagine CIImage con le

opzioni prima definite

NSArray *features = [detector

featuresInImage:image

options:imageOptions];](https://image.slidesharecdn.com/mokapp2014-danielegaliotto-140626124558-phpapp02/85/Mokapp2014-Daniele-Galiotto-Camera-e-sorrisi-21-320.jpg)

![[DEMO]](https://image.slidesharecdn.com/mokapp2014-danielegaliotto-140626124558-phpapp02/85/Mokapp2014-Daniele-Galiotto-Camera-e-sorrisi-23-320.jpg)

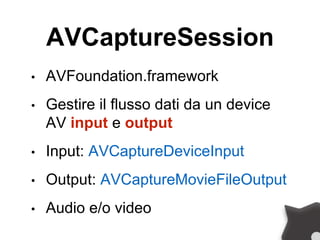

![AVCaptureSession

• [session setSessionPreset:…]]

Il metodo setSessionPreset permette di

customizzare qualità, bitrate, e altri

settings per l’output.

Presets di defaults sono già disponibili

nella classe AVCaptureSession.](https://image.slidesharecdn.com/mokapp2014-danielegaliotto-140626124558-phpapp02/85/Mokapp2014-Daniele-Galiotto-Camera-e-sorrisi-26-320.jpg)

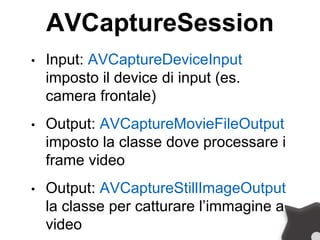

![AVCaptureSession

• Input e output vanno poi aggiunti

alla sessione che li userà

if([session

canAddOutput:stillImageOutput])

[session addOutput:stillImageOutput];](https://image.slidesharecdn.com/mokapp2014-danielegaliotto-140626124558-phpapp02/85/Mokapp2014-Daniele-Galiotto-Camera-e-sorrisi-28-320.jpg)

![AVCaptureSession

AVCaptureSession *captureSession = [[AVCaptureSession alloc] init];

AVCaptureDevice *audioCaptureDevice = [AVCaptureDevice

defaultDeviceWithMediaType:AVMediaTypeAudio];

NSError *error = nil;

AVCaptureDeviceInput *audioInput = [AVCaptureDeviceInput

deviceInputWithDevice:audioCaptureDevice error:&error];

if (audioInput) {

[captureSession addInput:audioInput];

}

Audio Capture Session](https://image.slidesharecdn.com/mokapp2014-danielegaliotto-140626124558-phpapp02/85/Mokapp2014-Daniele-Galiotto-Camera-e-sorrisi-29-320.jpg)

![AVCaptureSession

• [session startRunning]

• [session stopRunning]

I metodi startRunning e stopRunning sono

bloccanti perciò, per “liberare” il thread

principale, andrebbero eseguiti in modo

asincrono in una coda seriale (FIFO)

DISPATCH_QUEUE_SERIAL.](https://image.slidesharecdn.com/mokapp2014-danielegaliotto-140626124558-phpapp02/85/Mokapp2014-Daniele-Galiotto-Camera-e-sorrisi-32-320.jpg)

![AVCaptureSession

dispatch_async([self sessionQueue],

^{…

[session startRunning];

…});](https://image.slidesharecdn.com/mokapp2014-danielegaliotto-140626124558-phpapp02/85/Mokapp2014-Daniele-Galiotto-Camera-e-sorrisi-33-320.jpg)

![AVCaptureSession

• [session beginConfiguration]

• [session commitConfiguration]

Permettono di aggiornare al volo la

sessione (es. per saltare dalla fotocamera

anteriore alla posteriore e viceversa)](https://image.slidesharecdn.com/mokapp2014-danielegaliotto-140626124558-phpapp02/85/Mokapp2014-Daniele-Galiotto-Camera-e-sorrisi-34-320.jpg)

![[DEMO]](https://image.slidesharecdn.com/mokapp2014-danielegaliotto-140626124558-phpapp02/85/Mokapp2014-Daniele-Galiotto-Camera-e-sorrisi-40-320.jpg)

![[GRAZIAS]

Freelance

Senior iOS

Developer

www.g8production.

com

genius@g8production.

com](https://image.slidesharecdn.com/mokapp2014-danielegaliotto-140626124558-phpapp02/85/Mokapp2014-Daniele-Galiotto-Camera-e-sorrisi-41-320.jpg)