Adaline Inteligencia Artificial

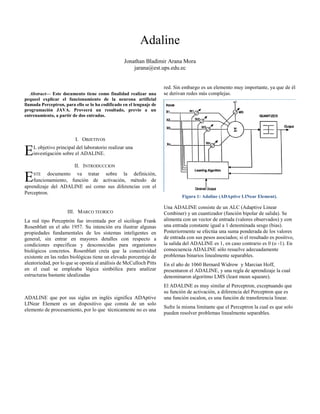

- 1. Abstract— Este documento tiene como finalidad realizar una pequeel explicar el funcionamiento de la neurona artificial llamada Perceptron, para ello se lo ha codificado en el lenguaje de programación JAVA. Proveerá un resultado, previo a un entrenamiento, a partir de dos entradas. I. OBJETIVOS L objetivo principal del laboratorio realizar una investigación sobre el ADALINE. II. INTRODUCCION STE documento va tratar sobre la definición, funcionamiento, función de activación, método de aprendizaje del ADALINE así como sus diferencias con el Perceptron. III. MARCO TEORICO La red tipo Perceptrón fue inventada por el sicólogo Frank Rosenblatt en el año 1957. Su intención era ilustrar algunas propiedades fundamentales de los sistemas inteligentes en general, sin entrar en mayores detalles con respecto a condiciones específicas y desconocidas para organismos biológicos concretos. Rosenblatt creía que la conectividad existente en las redes biológicas tiene un elevado porcentaje de aleatoriedad, por lo que se oponía al análisis de McCulloch Pitts en el cual se empleaba lógica simbólica para analizar estructuras bastante idealizadas ADALINE que por sus siglas en inglés significa ADAptive LINear Element es un dispositivo que consta de un solo elemento de procesamiento, por lo que técnicamente no es una red. Sin embargo es un elemento muy importante, ya que de él se derivan redes más complejas. Figura 1: Adaline (ADAptive LINear Element). Una ADALINE consiste de un ALC (Adaptive Linear Combiner) y un cuantizador (función bipolar de salida). Se alimenta con un vector de entrada (valores observados) y con una entrada constante igual a 1 denominada sesgo (bias). Posteriormente se efectúa una suma ponderada de los valores de entrada con sus pesos asociados; si el resultado es positivo, la salida del ADALINE es 1, en caso contrario es 0 (o -1). En consecuencia ADALINE sólo resuelve adecuadamente problemas binarios linealmente separables. En el año de 1060 Bernard Widrow y Marcian Hoff, presentaron el ADALINE, y una regla de aprendizaje la cual denominaron algoritmo LMS (least mean squeare). El ADALINE es muy similar al Perceptron, exceptuando que su función de activación, a diferencia del Perceptron que es una función escalon, es una función de transferencia linear. Sufre la misma limitante que el Perceptron la cual es que solo pueden resolver problemas linealmente separables. Adaline Jonathan Bladimir Arana Mora jarana@est.ups.edu.ec E E

- 2. Figura 2: Estructura de un ADALINE Método de Aprendizaje. Figura 3: Arquitectura Adaline. Para su aprendizaje el ADALINE utiliza el algoritmo LMS. También llamado del algoritmo de Widrow-Hoff. Consiste en ajustar los pesos para minimizar el mse (mean squeare error). Sea un conjunto de entradas: Se aplican las Q entradas calculando cada error como la diferencia entre el objetivo y la salida. Se desea minimizar el promedio de los cuadrados de estos errores: e2(w) = (t - a(w))2 ∇𝐸 = 1 𝑄 ∑ ∇𝑒2(𝑤) 𝑄 𝑘=1 𝑊 = 𝑊−∝ ∇𝐸 Diferencias con Perceptron. El algoritmo LMS es más poderoso que la regla de aprendizaje del Perceptron. La regla del Perceptron garantiza la convergencia a una solución que categoriza correctamente el patrón de entrenamiento, pero la red resultante puede ser sensible al ruido ya que frecuentemente el modelo cae cerca de la frontera de decisión. El algoritmo LMS minimiza el error medio cuadrático, y por consiguiente trata de mover la frontera de decisión tan lejos como sea posible del modelo de entrenamiento. El algoritmo LMS ha encontrado muchos más usos que la regla de aprendizaje del Perceptron. En esencia en el área del procesamiento digital de señales.

- 3. PERCEPTRON ADALINE Función de Transferencia ESCALON LINEAL Resolución de problemas Linealmente Separables Linealment e Separables Comportamiento con respecto al RUIDO Sensible al Ruido Minimiza el Ruido Algoritmo de aprendizaje Regla de aprendizaje del Perceptron LMS La tabla resumen las principales y más importantes diferencias del Perceptron con respecto al ADALINE. IV. CONCLUSIONES Se realizó una investigación sobre las redes neuronales en la inteligencia artificial. Se obtuvo información para realizar la consulta sobre el ADALINE, tanto como para su definición y sus diferencias con su predecesor el PERCEPTRON. Se pudo conocer de la limitación del Perceptron, y sobre lo que se mejoró en el ADALINE. REFERENCES [1] “PERCEPTRÓN.” WIKIPEDIA, LA ENCICLOPEDIA LIBRE, JUNIO 19, 2014. [2]http://www.ayc.unavarra.es/miguel.pagola/Redes %20Neuronales.pdf [3]http://www.geofisica.cl/English/pics3/FUM6.ht m [4]http://moisesrbb.tripod.com/unidad1.htmhttp [5]http://www.zator.com/Hardware/H1_7_1.htm [6]http://delta.cs.cinvestav.mx/~ccoello/revistas/gen etico.pdf.gz [7] Smith, Robert E.; Goldberg, David, E. y Earickson, Jeff A. "SGA-C : A C-language Implementation of a Simple Genetic Algorithm", TCGA Report No. 91002, The Clearinghouse for Genetic Algorithms, The University of Alabama, Mayo 14 de 1991. [8] Filho, José L. Ribeiro; Treleaven, Philip C. y Alippi, Cesare. "Genetic-Algorithm Programming Environments", en IEEE Computer, Junio de 1994, pp. 28-43.